실습 환경 배포

AWS CloudFormation 통한 실습 환경 배포

# yaml 파일 다운로드

curl -O https://s3.ap-northeast-2.amazonaws.com/cloudformation.cloudneta.net/K8S/myeks-3week.yaml

# 배포

aws cloudformation deploy --template-file /root/aews/3week/myeks-3week.yaml --stack-name myeks --parameter-overrides KeyName=<MY KEY> SgIngressSshCidr=$(curl -s ipinfo.io/ip)/32 --region ap-northeast-2

# CloudFormation 스택 배포 완료 후 운영서버 EC2 IP 출력

aws cloudformation describe-stacks --stack-name myeks --query 'Stacks[*].Outputs[*].OutputValue' --output text

# 운영서버 EC2 에 SSH 접속

ssh -i <MY KEY> ec2-user@$(aws cloudformation describe-stacks --stack-name myeks --query 'Stacks[*].Outputs[0].OutputValue' --output text)

eksctl 통해 EKS 배포

YAML 파일 작성

export CLUSTER_NAME=myeks

# myeks-VPC/Subnet 정보 확인 및 변수 지정

export VPCID=$(aws ec2 describe-vpcs --filters "Name=tag:Name,Values=$CLUSTER_NAME-VPC" --query 'Vpcs[*].VpcId' --output text)

echo $VPCID

export PubSubnet1=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet1" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet2=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet2" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet3=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet3" --query "Subnets[0].[SubnetId]" --output text)

echo $PubSubnet1 $PubSubnet2 $PubSubnet3

myeks.yaml 파일 작성

VPC, Subnet, SSH Key는 각자 환경에 맞게 수정

cat << EOF > myeks.yaml

apiVersion: eksctl.io/v1alpha5

kind: ClusterConfig

metadata:

name: myeks

region: ap-northeast-2

version: "1.31"

iam:

withOIDC: true # enables the IAM OIDC provider as well as IRSA for the Amazon CNI plugin

serviceAccounts: # service accounts to create in the cluster. See IAM Service Accounts

- metadata:

name: aws-load-balancer-controller

namespace: kube-system

wellKnownPolicies:

awsLoadBalancerController: true

vpc:

cidr: 192.168.0.0/16

clusterEndpoints:

privateAccess: true # if you only want to allow private access to the cluster

publicAccess: true # if you want to allow public access to the cluster

id: vpc-07b0de2f236f51919

subnets:

public:

ap-northeast-2a:

az: ap-northeast-2a

cidr: 192.168.1.0/24

id: subnet-060a113839ec47377

ap-northeast-2b:

az: ap-northeast-2b

cidr: 192.168.2.0/24

id: subnet-0c2973de886956a75

ap-northeast-2c:

az: ap-northeast-2c

cidr: 192.168.3.0/24

id: subnet-0f1c6a2edd2f89e25

addons:

- name: vpc-cni # no version is specified so it deploys the default version

version: latest # auto discovers the latest available

attachPolicyARNs: # attach IAM policies to the add-on's service account

- arn:aws:iam::aws:policy/AmazonEKS_CNI_Policy

configurationValues: |-

enableNetworkPolicy: "true"

- name: kube-proxy

version: latest

- name: coredns

version: latest

- name: metrics-server

version: latest

managedNodeGroups:

- amiFamily: AmazonLinux2023

desiredCapacity: 3

iam:

withAddonPolicies:

certManager: true # Enable cert-manager

externalDNS: true # Enable ExternalDNS

instanceType: t3.medium

preBootstrapCommands:

# install additional packages

- "dnf install nvme-cli links tree tcpdump sysstat ipvsadm ipset bind-utils htop -y"

labels:

alpha.eksctl.io/cluster-name: myeks

alpha.eksctl.io/nodegroup-name: ng1

maxPodsPerNode: 100

maxSize: 3

minSize: 3

name: ng1

ssh:

allow: true

publicKeyName: <MY KEY>

tags:

alpha.eksctl.io/nodegroup-name: ng1

alpha.eksctl.io/nodegroup-type: managed

volumeIOPS: 3000

volumeSize: 120

volumeThroughput: 125

volumeType: gp3

EOF

EKS 정보 확인

#

kubectl cluster-info

# 네임스페이스 default 변경 적용

kubens default

#

kubectl ctx

kubectl config rename-context "<각자 자신의 IAM User>@myeks.ap-northeast-2.eksctl.io" "eksworkshop"

#

kubectl get node --label-columns=node.kubernetes.io/instance-type,eks.amazonaws.com/capacityType,topology.kubernetes.io/zone

kubectl get node -v=6

#

kubectl get pod -A

kubectl get pdb -n kube-system

# 관리형 노드 그룹 확인

eksctl get nodegroup --cluster $CLUSTER_NAME

aws eks describe-nodegroup --cluster-name $CLUSTER_NAME --nodegroup-name ng1 | jq

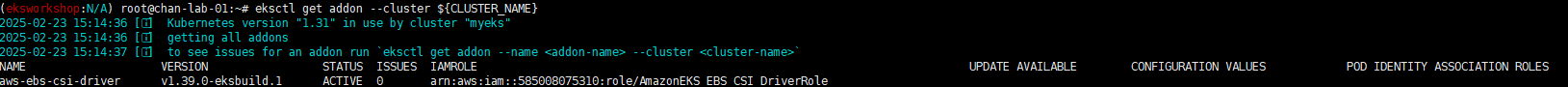

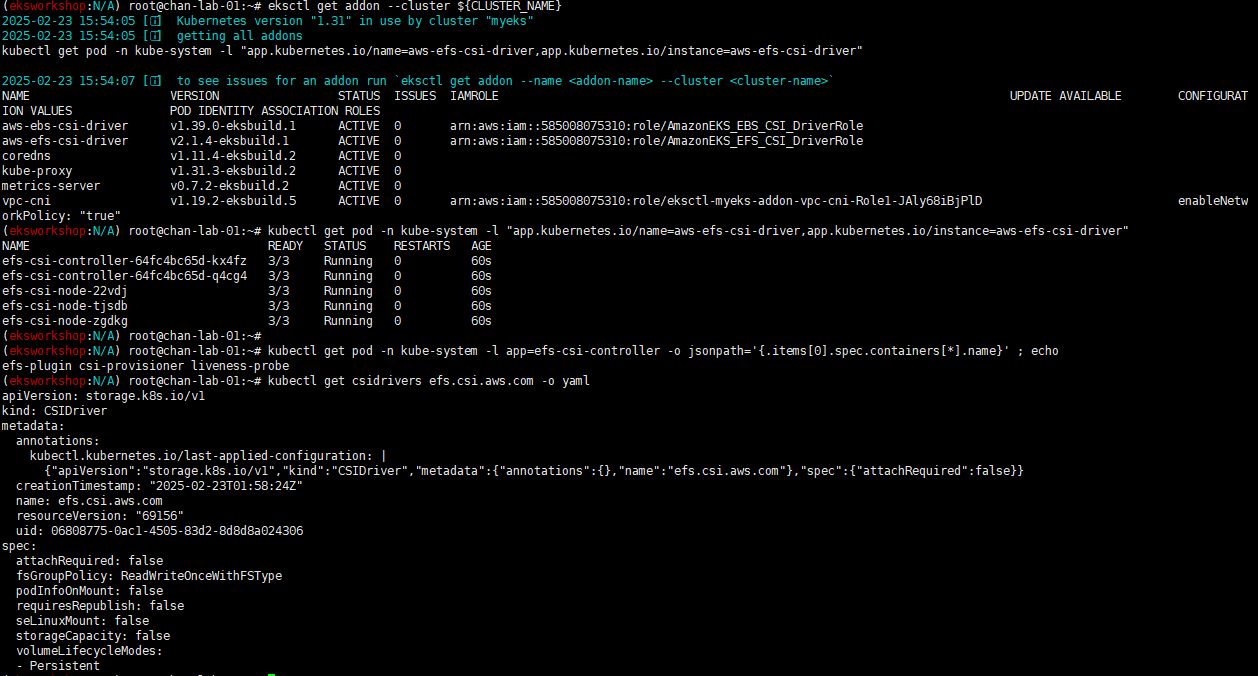

# eks addon 확인

eksctl get addon --cluster $CLUSTER_NAME

# aws-load-balancer-controller를 위한 iam service account 생성 확인 : AWS IAM role bound to a Kubernetes service account

eksctl get iamserviceaccount --cluster $CLUSTER_NAME

관리형 노드 그룹(EC2) 접속 및 노드 정보 확인

# 인스턴스 정보 확인 1

aws ec2 describe-instances --query "Reservations[*].Instances[*].{InstanceID:InstanceId, PublicIPAdd:PublicIpAddress, PrivateIPAdd:PrivateIpAddress, InstanceName:Tags[?Key=='Name']|[0].Value, Status:State.Name}" --filters Name=instance-state-name,Values=running --output table

# 인스턴스 정보 확인 2 : AZ, ID, 공인IP

aws ec2 describe-instances \

--filters "Name=tag:Name,Values=myeks-ng1-Node" \

--query "Reservations[].Instances[].{InstanceID:InstanceId, PublicIP:PublicIpAddress, AZ:Placement.AvailabilityZone}" \

--output table

# AZ1 배치된 EC2 공인 IP

aws ec2 describe-instances \

--filters "Name=tag:Name,Values=myeks-ng1-Node" "Name=availability-zone,Values=ap-northeast-2a" \

--query 'Reservations[*].Instances[*].PublicIpAddress' \

--output text

# AZ2 배치된 EC2 공인 IP

aws ec2 describe-instances \

--filters "Name=tag:Name,Values=myeks-ng1-Node" "Name=availability-zone,Values=ap-northeast-2b" \

--query 'Reservations[*].Instances[*].PublicIpAddress' \

--output text

# AZ3 배치된 EC2 공인 IP

aws ec2 describe-instances \

--filters "Name=tag:Name,Values=myeks-ng1-Node" "Name=availability-zone,Values=ap-northeast-2c" \

--query 'Reservations[*].Instances[*].PublicIpAddress' \

--output text

# EC2 공인 IP 변수 지정

export N1=$(aws ec2 describe-instances --filters "Name=tag:Name,Values=myeks-ng1-Node" "Name=availability-zone,Values=ap-northeast-2a" --query 'Reservations[*].Instances[*].PublicIpAddress' --output text)

export N2=$(aws ec2 describe-instances --filters "Name=tag:Name,Values=myeks-ng1-Node" "Name=availability-zone,Values=ap-northeast-2b" --query 'Reservations[*].Instances[*].PublicIpAddress' --output text)

export N3=$(aws ec2 describe-instances --filters "Name=tag:Name,Values=myeks-ng1-Node" "Name=availability-zone,Values=ap-northeast-2c" --query 'Reservations[*].Instances[*].PublicIpAddress' --output text)

echo $N1, $N2, $N3

# *remoteAccess* 포함된 보안그룹 ID

aws ec2 describe-security-groups --filters "Name=group-name,Values=*remoteAccess*" | jq

export MNSGID=$(aws ec2 describe-security-groups --filters "Name=group-name,Values=*remoteAccess*" --query 'SecurityGroups[*].GroupId' --output text)

# 해당 보안그룹 inbound 에 접속할 공인 IP 룰 추가

aws ec2 authorize-security-group-ingress --group-id $MNSGID --protocol '-1' --cidr $(curl -s ipinfo.io/ip)/32

# 해당 보안그룹 inbound 에 운영서버 내부 IP 룰 추가

aws ec2 authorize-security-group-ingress --group-id $MNSGID --protocol '-1' --cidr 172.20.1.100/32

# ping 테스트

ping -c 2 $N1

ping -c 2 $N2

ping -c 2 $N3

# 워커 노드 SSH 접속

ssh -i <SSH 키> -o StrictHostKeyChecking=no ec2-user@$N1 hostname

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh -o StrictHostKeyChecking=no ec2-user@$i hostname; echo; done

노드 정보 확인 및 Max-Pods 정보 확인

# 노드 기본 정보 확인

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i hostnamectl; echo; done

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i sudo ip -c addr; echo; done

#

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i lsblk; echo; done

for i in $N1 $N2 $N3; do echo ">> node $i <<"; ssh ec2-user@$i df -hT /; echo; done

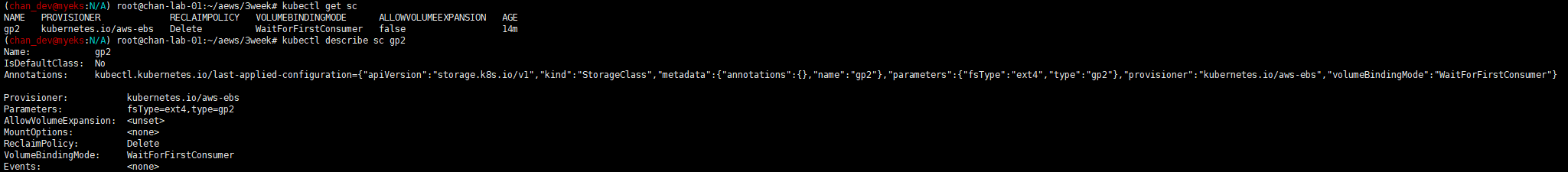

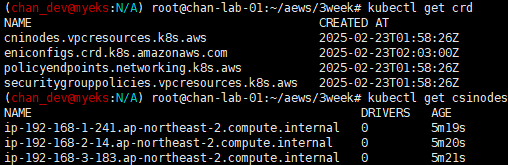

# 스토리지클래스 및 CSI 노드 확인

kubectl get sc

kubectl describe sc gp2

kubectl get crd

kubectl get csinodes

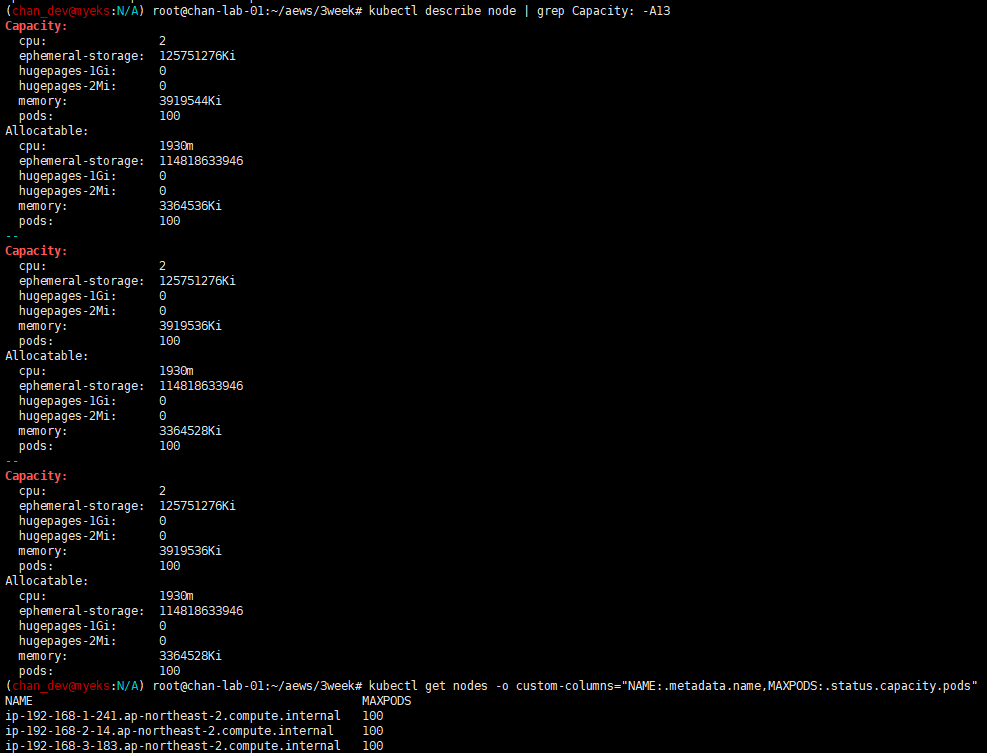

# max-pods 정보 확인

kubectl describe node | grep Capacity: -A13

kubectl get nodes -o custom-columns="NAME:.metadata.name,MAXPODS:.status.capacity.pods"

운영서버 EFS 마운트 테스트

EKS kubeconfig 설정

# eks 설치한 iam 자격증명을 설정하기

aws configure

# get-caller-identity 확인

aws sts get-caller-identity --query Arn

# kubeconfig 생성

aws eks update-kubeconfig --name myeks --user-alias <위 출력된 자격증명 사용자>

aws eks update-kubeconfig --name myeks --user-alias admin

#

kubectl cluster-info

kubectl ns default

kubectl get node -v6

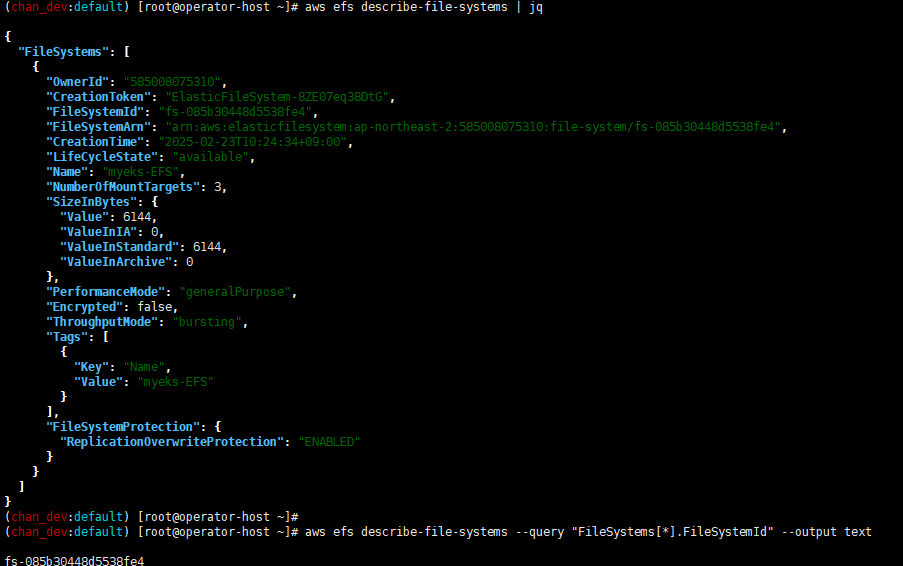

EFS 마운트 테스트

# 현재 EFS 정보 확인

aws efs describe-file-systems | jq

# 파일 시스템 ID만 출력

aws efs describe-file-systems --query "FileSystems[*].FileSystemId" --output text

fs-040469b8fab273469

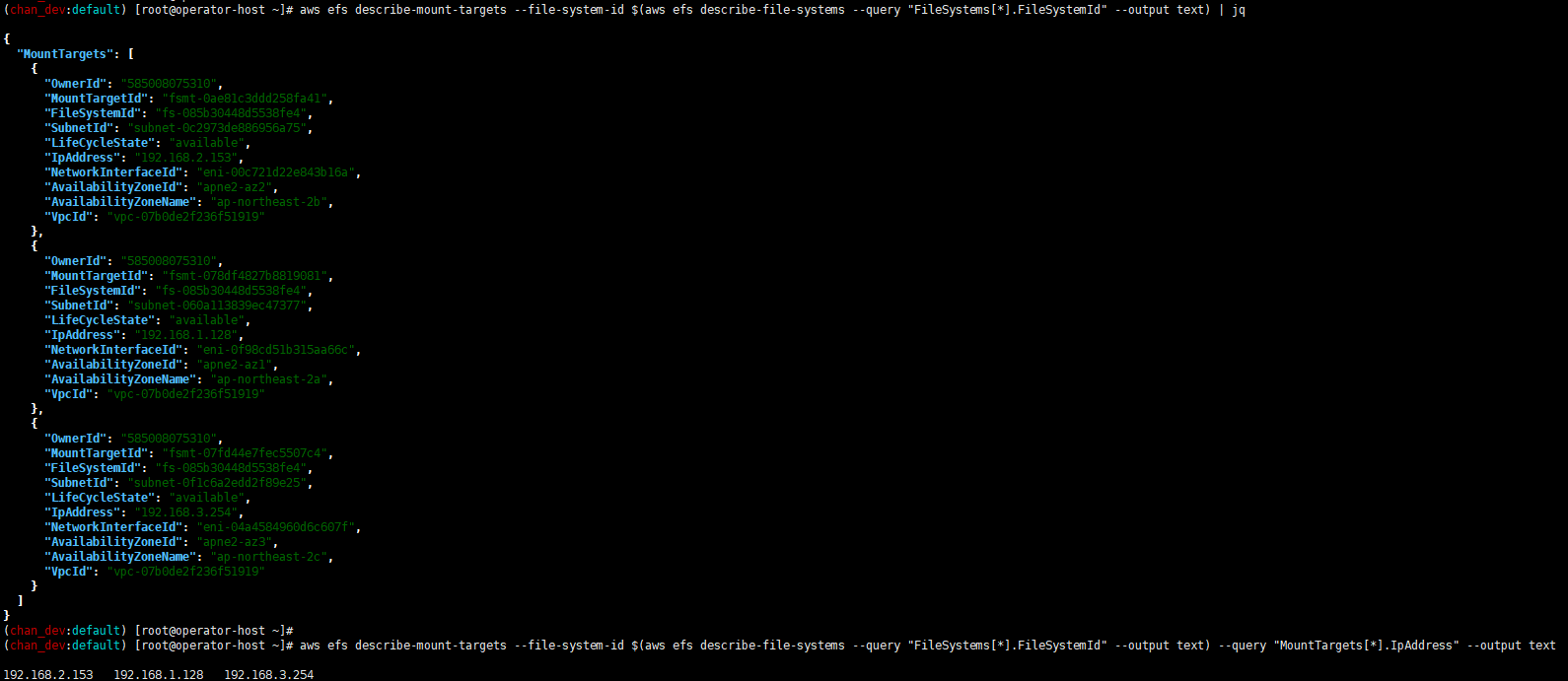

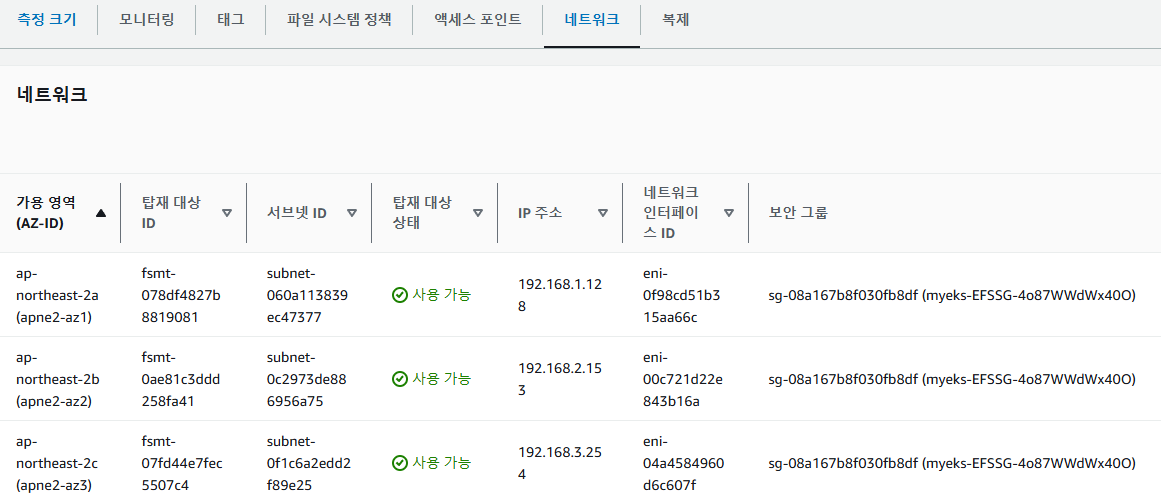

# EFS 마운트 대상 정보 확인

aws efs describe-mount-targets --file-system-id $(aws efs describe-file-systems --query "FileSystems[*].FileSystemId" --output text) | jq

# IP만 출력 :

aws efs describe-mount-targets --file-system-id $(aws efs describe-file-systems --query "FileSystems[*].FileSystemId" --output text) --query "MountTargets[*].IpAddress" --output text

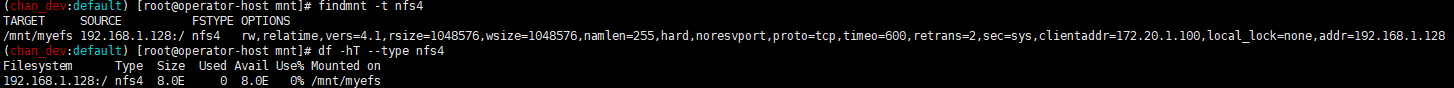

# EFS 마운트 테스트

EFSIP1=<출력된 IP 중 한개 IP 지정>

df -hT

mkdir /mnt/myefs

mount -t nfs4 -o nfsvers=4.1,rsize=1048576,wsize=1048576,hard,timeo=600,retrans=2,noresvport $EFSIP1:/ /mnt/myefs

findmnt -t nfs4

df -hT --type nfs4

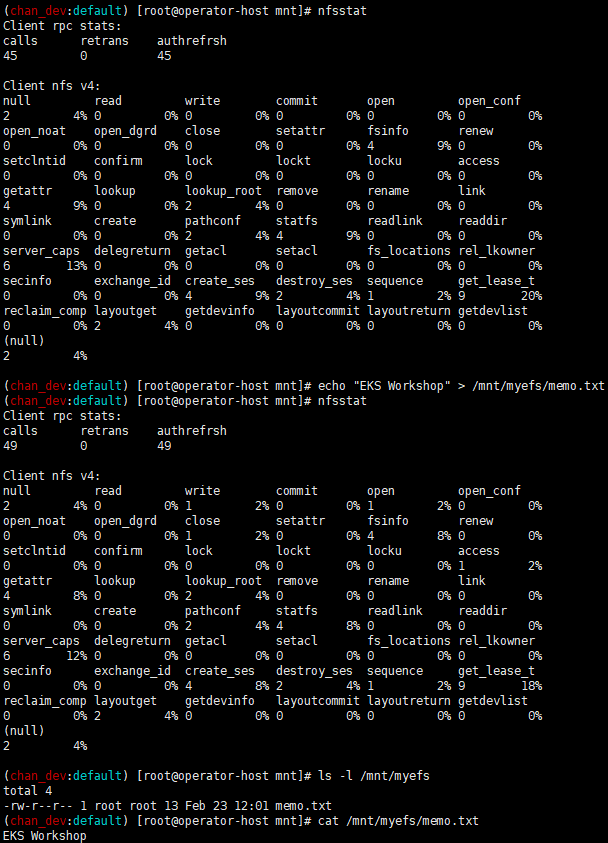

# 파일 작성

nfsstat

echo "EKS Workshop" > /mnt/myefs/memo.txt

nfsstat

ls -l /mnt/myefs

cat /mnt/myefs/memo.txt

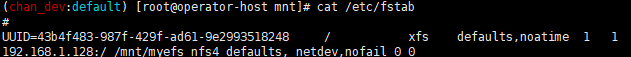

# EC2 재부팅 이후에도 mount 탑재 될 수 있게 설정 하기

vim /etc/fstab

192.168.1.128:/ /mnt/myefs nfs4 defaults,_netdev,nofail 0 0

배포 후 실습 편의를 위한 설정

# 실습 완료 후 삭제!!

MyDomain=yandhi.link # 각자 자신의 도메인 이름 입력

MyDnzHostedZoneId=$(aws route53 list-hosted-zones-by-name --dns-name "$MyDomain." --query "HostedZones[0].Id" --output text)

cat << EOF >> ~/.bashrc

# eksworkshop

export CLUSTER_NAME=myeks

export VPCID=$(aws ec2 describe-vpcs --filters "Name=tag:Name,Values=$CLUSTER_NAME-VPC" --query 'Vpcs[*].VpcId' --output text)

export PubSubnet1=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet1" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet2=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet2" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet3=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet3" --query "Subnets[0].[SubnetId]" --output text)

export N1=$(aws ec2 describe-instances --filters "Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node" "Name=availability-zone,Values=ap-northeast-2a" --query 'Reservations[*].Instances[*].PublicIpAddress' --output text)

export N2=$(aws ec2 describe-instances --filters "Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node" "Name=availability-zone,Values=ap-northeast-2b" --query 'Reservations[*].Instances[*].PublicIpAddress' --output text)

export N3=$(aws ec2 describe-instances --filters "Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node" "Name=availability-zone,Values=ap-northeast-2c" --query 'Reservations[*].Instances[*].PublicIpAddress' --output text)

MyDomain=yandhi.link # 각자 자신의 도메인 이름 입력

MyDnzHostedZoneId=$(aws route53 list-hosted-zones-by-name --dns-name "$MyDomain." --query "HostedZones[0].Id" --output text)

EOF

# 확인

echo $CLUSTER_NAME $VPCID $PubSubnet1 $PubSubnet2 $PubSubnet3

echo $N1 $N2 $N3 $MyDomain $MyDnzHostedZoneId

tail -n 12 ~/.bashrc

AWS LoadBalancerController, ExternalDNS, kube-ops-view 설치

# kube-ops-view

helm repo add geek-cookbook https://geek-cookbook.github.io/charts/

helm install kube-ops-view geek-cookbook/kube-ops-view --version 1.2.2 --set service.main.type=ClusterIP --set env.TZ="Asia/Seoul" --namespace kube-system

# AWS LoadBalancerController

helm repo add eks https://aws.github.io/eks-charts

helm repo update

kubectl get sa -n kube-system aws-load-balancer-controller

helm install aws-load-balancer-controller eks/aws-load-balancer-controller -n kube-system --set clusterName=$CLUSTER_NAME \

--set serviceAccount.create=false --set serviceAccount.name=aws-load-balancer-controller

# ExternalDNS

MyDomain=yandhi.link

MyDnzHostedZoneId=$(aws route53 list-hosted-zones-by-name --dns-name "$MyDomain." --query "HostedZones[0].Id" --output text)

curl -s https://raw.githubusercontent.com/gasida/PKOS/main/aews/externaldns.yaml | MyDomain=$MyDomain MyDnzHostedZoneId=$MyDnzHostedZoneId envsubst | kubectl apply -f -

# 사용 리전의 인증서 ARN 확인 : 정상 상태 확인(만료 상태면 에러 발생!)

CERT_ARN=$(aws acm list-certificates --query 'CertificateSummaryList[].CertificateArn[]' --output text)

echo $CERT_ARN

# kubeopsview 용 Ingress 설정 : group 설정으로 1대의 ALB를 여러개의 ingress 에서 공용 사용

cat <<EOF | kubectl apply -f -

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

annotations:

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/load-balancer-name: myeks-ingress-alb

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/ssl-redirect: "443"

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/target-type: ip

labels:

app.kubernetes.io/name: kubeopsview

name: kubeopsview

namespace: kube-system

spec:

ingressClassName: alb

rules:

- host: kubeopsview.$MyDomain

http:

paths:

- backend:

service:

name: kube-ops-view

port:

number: 8080

path: /

pathType: Prefix

EOF

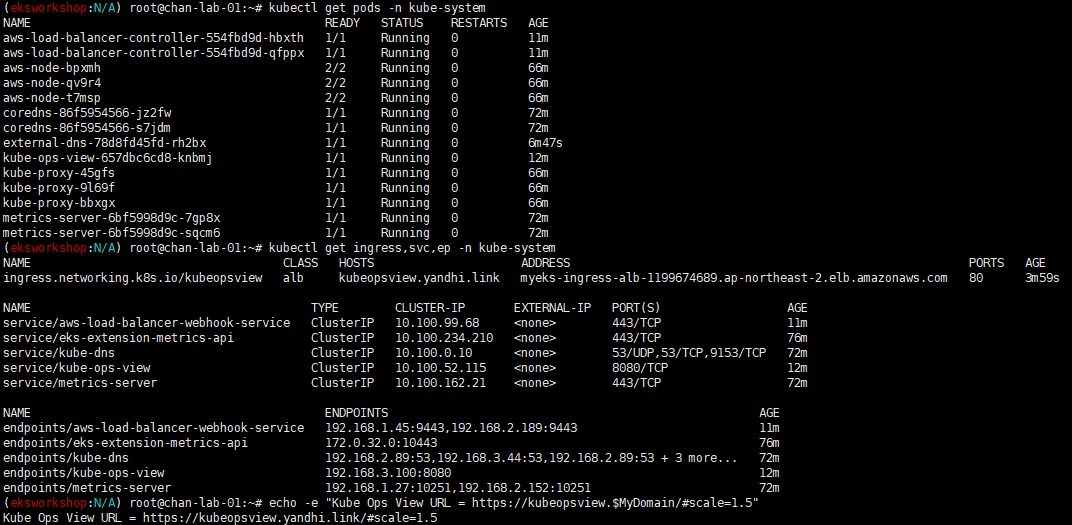

확인

# 설치된 파드 정보 확인

kubectl get pods -n kube-system

# service, ep, ingress 확인

kubectl get ingress,svc,ep -n kube-system

# Kube Ops View 접속 정보 확인

echo -e "Kube Ops View URL = https://kubeopsview.$MyDomain/#scale=1.5"

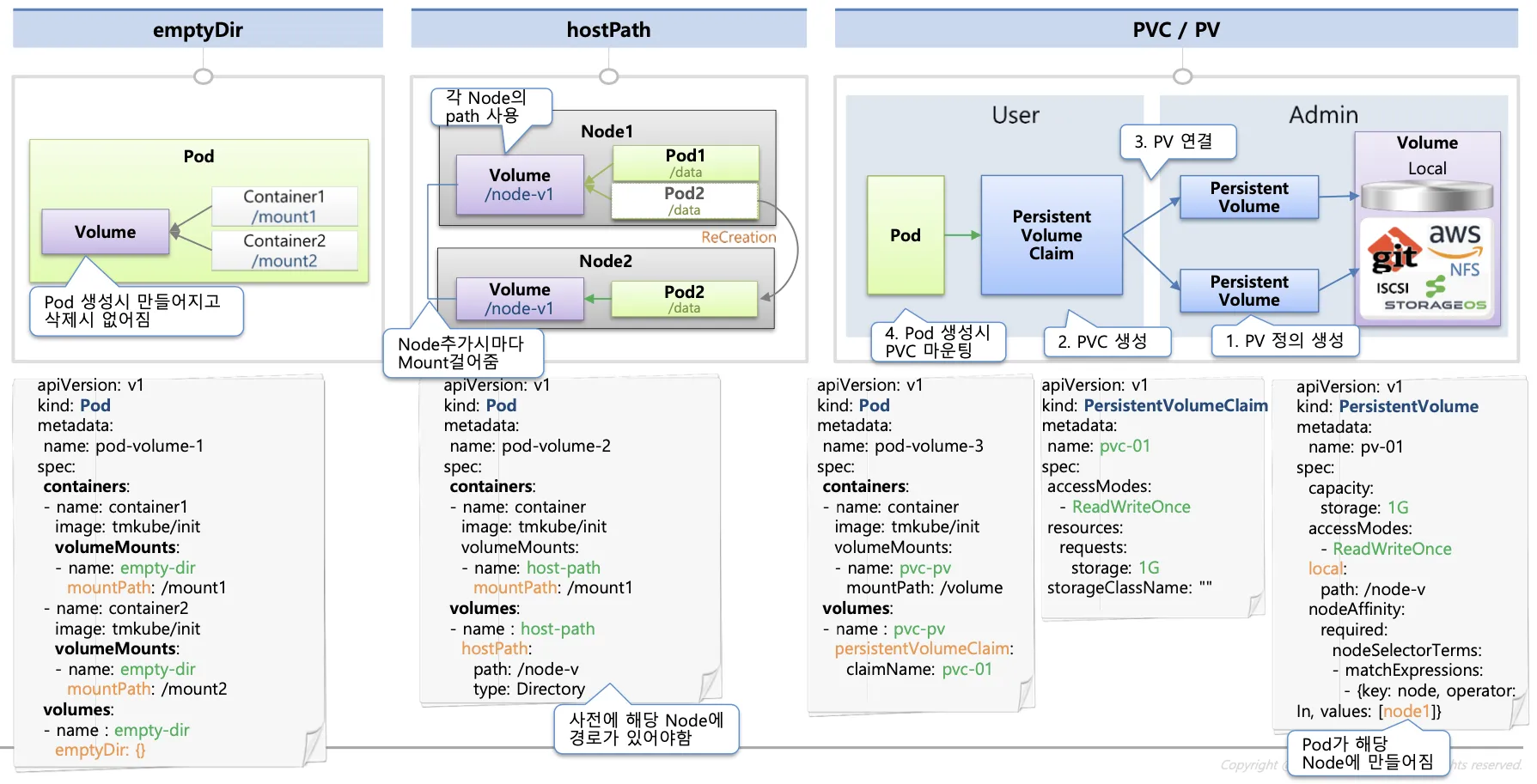

K8S 데이터 지속성

파드 내부 데이터는 파드가 삭제되면 모두 삭제됨. 즉, 파드 모두 상태가 없는(Stateless) 애플리케이션임

파드가 종료될 경우 데이터 손실을 방지하고 K8S에서 상태 저장 애플리케이션을 실행하려면 세 가지 스토리지 요구 사항을 준수해야함.

1. 스토리지는 Pod 수명 주기에 의존해서는 안됨

2. 스토리지는 K8S 클러스터의 모든 Pod 및 Node에서 사용할 수 있어야 함

3. 스토리지는 충돌이나 애플리케이션 오류에 관계없이 가용성이 높아야 함

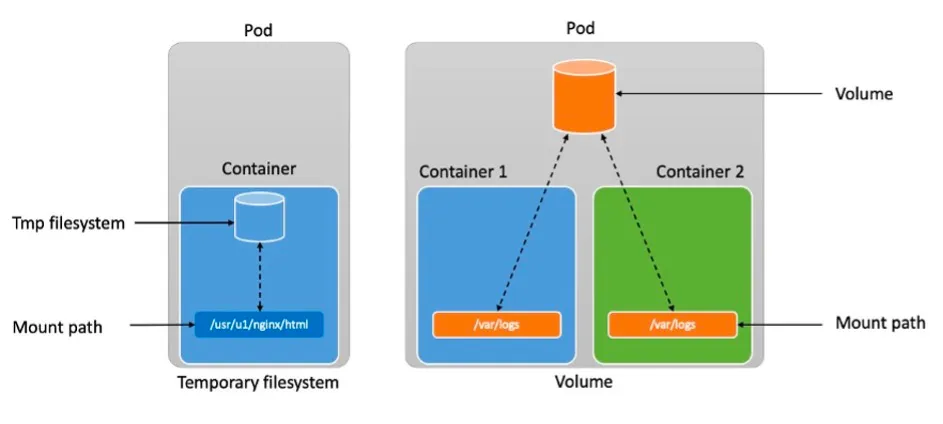

K8S Volume

K8S에는 여러 가지 유형의 스토리지 옵션이 있고 모두 영구적인 것은 아님

임시 스토리지(Ephemeral Storage)

컨테이너는 temporary filesystem(tmpfs)를 사용하여 파읽을 읽고 쓸 수 있음. 하지만 임시 스토리지는 세 가지 스토리지 요구 사항을 준수하지 않음. 컨테이너가 충돌하는 경우 temporary filesystem은 손실되고 컨테이너는 초기화 상태로 다시 시작됨.

또한 여러 컨테이너가 temporary filesystem을 공유할 수 없음.

임시 볼륨(Ephemeral Volumes)

임시 K8S 볼륨은 임시 스토리지가 직면한 두 가지 문제를 해결. 임시 볼륨의 수명은 Pod와 연결 됨.

이를 통해 컨테이너를 안전하게 재시작하고 Pod 내의 컨테이너 간 데이터를 공유할 수 있음.

하지만 Pod가 삭제되면 볼륨도 삭제되므로 세 가지 요구 사항을 만족하지는 못함.

스토리지와 Pod 분리

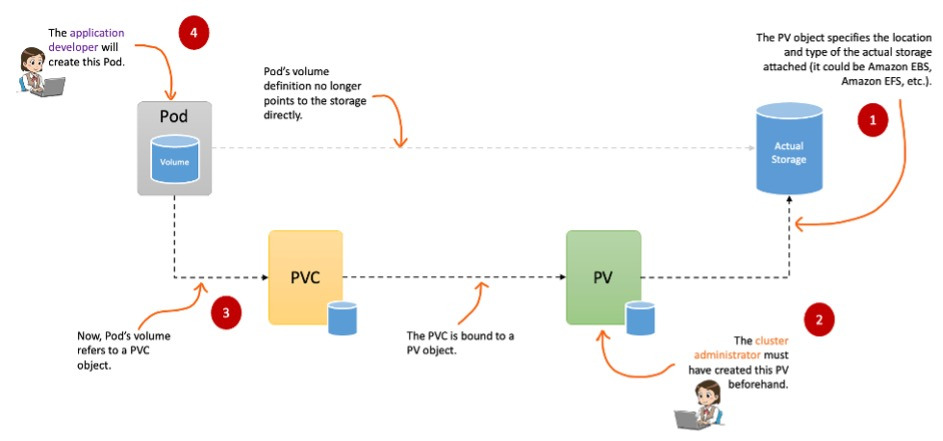

영구 볼륨(Persistent Volumes, PV)

K8S는 Persistent Volumes도 지원 함. Persistent Volumes을 사용하면 애플리케이션, 컨테이너, Pod, Node 또는 클러스터 자체의 수명 주기와 관계없이 데이터가 지속 저장됨.

Persistent Volumes은 세 가지 요구 사항을 충족함.

Persistent Volumes(PV) 객체는 애플리케이션 데이터를 유지하는데 사용되는 스토리지 볼륨을 나타냄.

PV는 K8S Pods의 수명 주기와 별개로 자체의 수명 주기를 가짐.

PV는 기본적으로 두가지로 구성

- PersistentVolume이라 불리는 백엔드 기술

- K8S에 볼륨을 마운트하는 방법을 알려주는 접근 모드

백엔드 기술(Backend Technology)

PV는 추상적인 구성 요소, 실존하는 물리 스토리지를 어딘가에서 가져와야 함.

- csi: Container Storage Interface(CSI) → Amazon EFS, Amazon EBS, Amazon FSx 등

- iscsi: iSCSI(SCSI over IP) 스토리지

- local: 노드에 마운트된 로컬 스토리지

- nfs: 네트워크 파일 시스템(NFS) 스토리지

K8S는 다양한 유형의 PV를 지원하며 연결되는 스토리지 내부에 신경 쓰지 않음.

PV는 세가지 주요 이점이 있음

- PV는 Pod의 수명 주기에 구속되지 않고 연결된 Pod를 삭제해도 해당 PV는 유지됨

- Pod가 충돌하더라도 PV는 유지됨, PV 객체는 장애 시에도 유지되고 클러스터에서 제거되지 않음

- PV는 클러스터 전체에 적용됨. 클러스터의 모든 노드에서 실행 중인 모든 Pod에서 연결할 수 있음

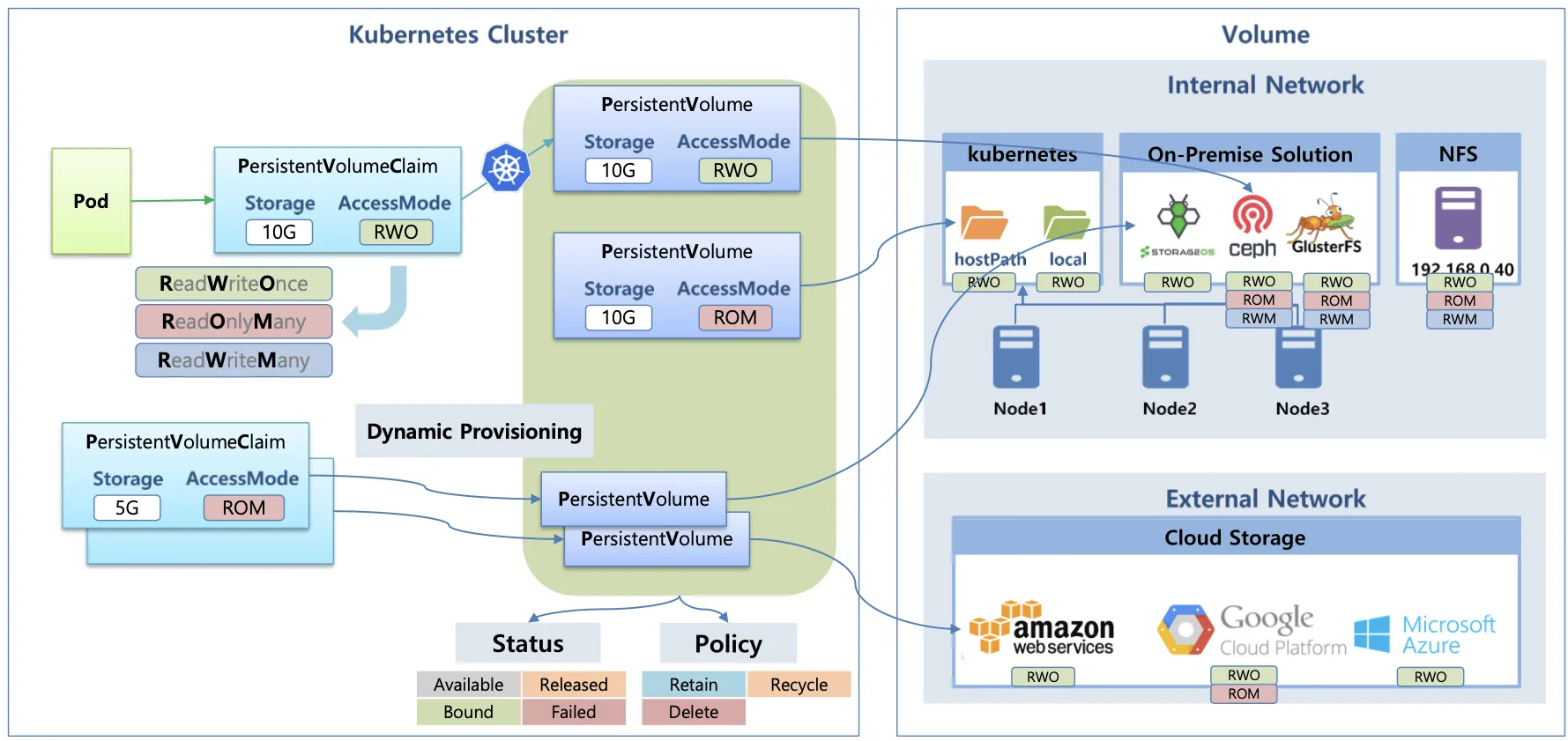

접근 모드(Access mode)

접근 모드는 PV가 생성될 때 설정되며 K8S가 볼륨을 마운트하는 방법을 알려줌. Persistent Volumes은 세 가지 접근 모드 지원

- ReadWriteOnce: 볼륨은 동시에 하나의 노드에서만 읽기/쓰기 허용

- ReadOnlyMany: 볼륨은 동시에 여러 노드에서 읽기 전용 모드 허용

- ReadWriteMany: 볼륨은 동시에 여러 노드에서 읽기/쓰기 허용

모든 Persistent Volume 유형이 모든 Access mode를 지원하는 것은 아님

영구 볼륨 클레임(Persistent Volume Claims)

Persistent Volume(PV)은 실제 스토리지 볼륨임. K8S는 PV를 Pod에 연결하는데 필요한 추가 추상화 계층인 PersistentVolumeClaim(PVC)을 가지고 있음

기본적으로 PV 객체를 직접 Pod에 마운트할 수 없고 명시적으로 요청되어져야 함.

그 요청은 PVC 객체를 생성하고 Pod에 연결하는 방식으로 달성됨.

PVC와 PV는 1:1로 연결되는 관계

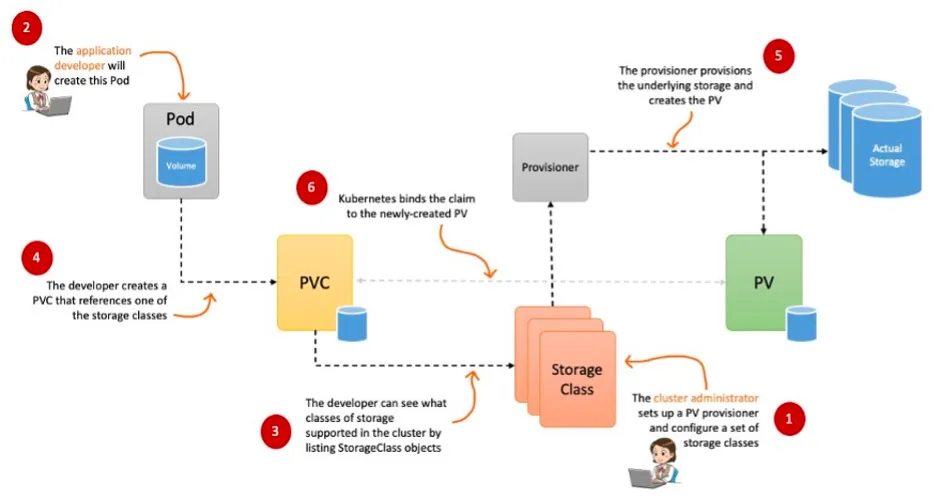

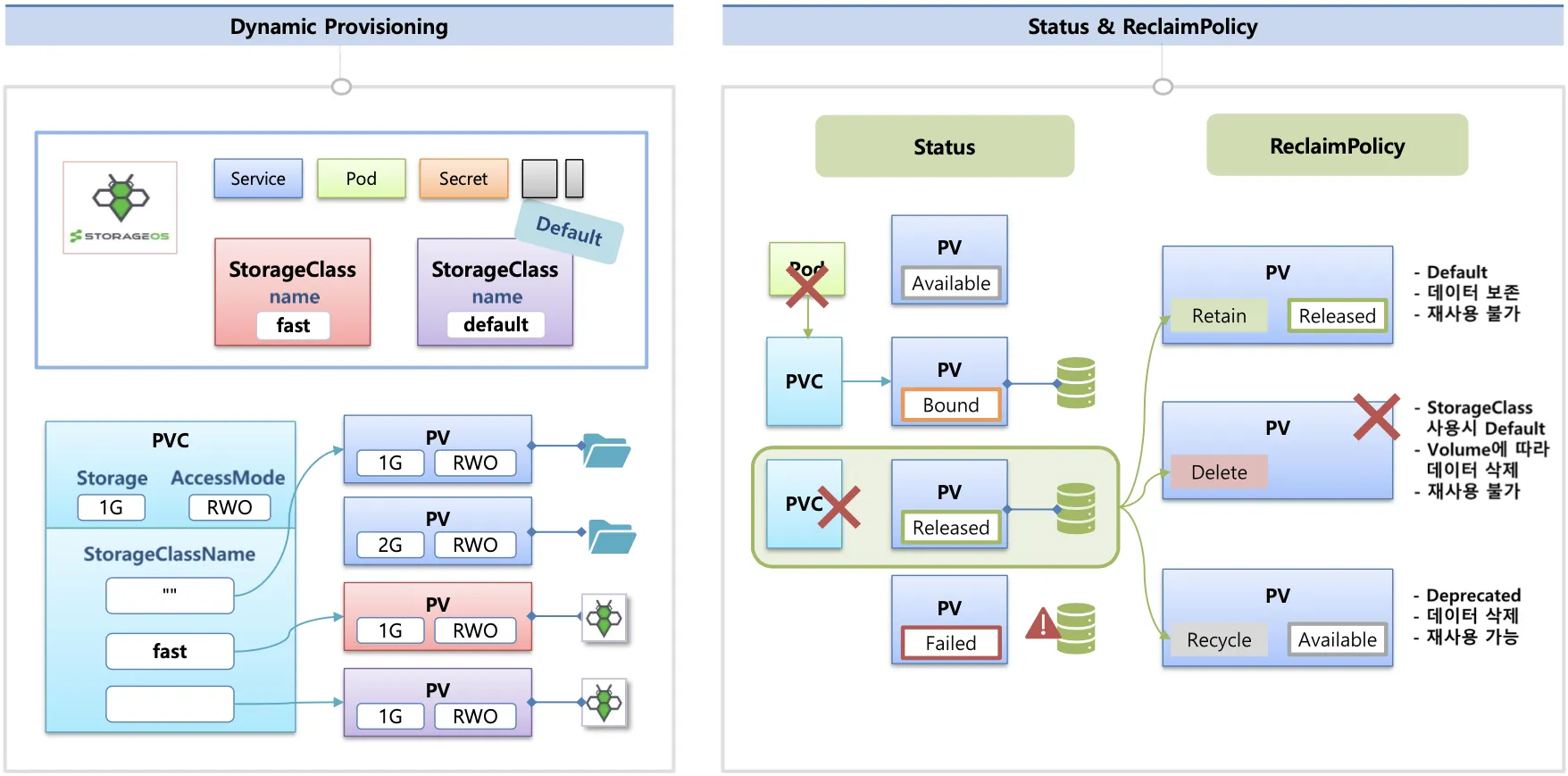

Pod가 생성될 때 자동으로 볼륨을 마운트하여 Pod에 연결하는 기능을 동적 프로비저닝(Dynamic Provisioning)이라고 함

Reclaim Policy

PersistentVolume 사용이 끝났을 때 해당 볼륨을 어떻게 초기화할 것인지 별도로 설정이 가능한데 이를 Reclaim Policy라고 부름

Reclaim Policy에는 크게 Retain(보존, Delete(삭제, 예를 들면 EBS 볼륨도 삭제됨) 방식이 있음

스토리지 소개

볼륨

emptyDir, hostPath, PV/PVC

다양한 볼륨 사용

K8S 자체 제공(hostpath, local), On-prem Solution(Ceph 등), NFS, 클라우드 스토리지(AWS EBS 등)

동적 프로비저닝 & 볼륨 상태, ReclaimPolicy

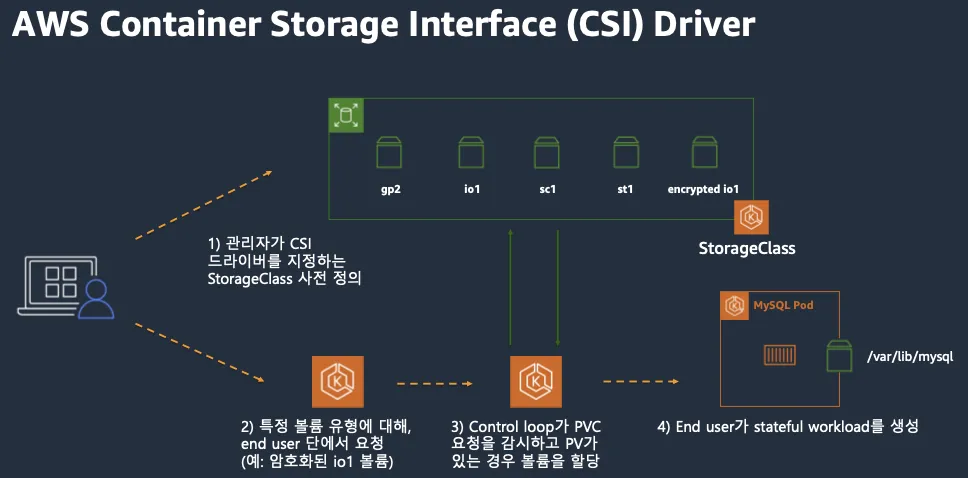

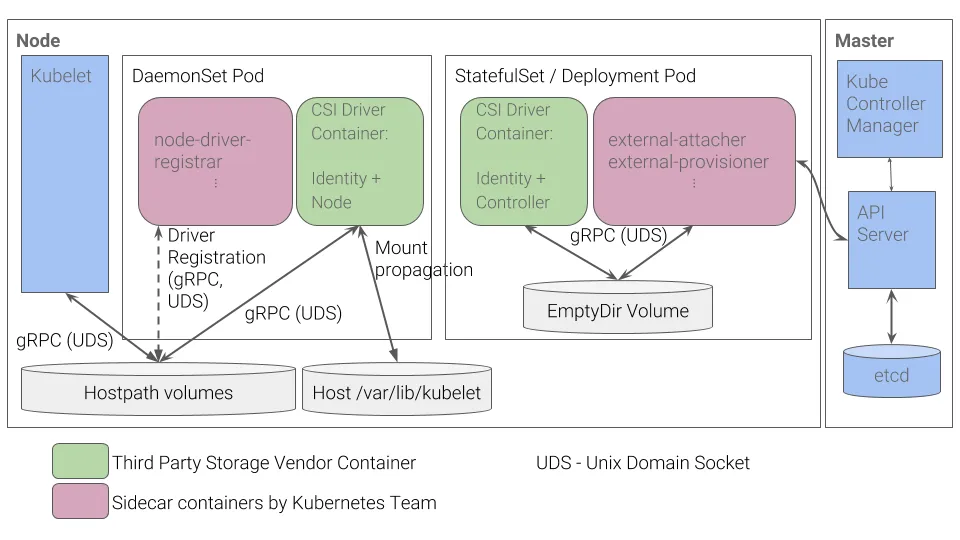

CSI (Container Storage Interface) 소개

CSI Driver 배경

K8S 소스 코드 내부에 존재하는 AWS EBS Provisioner는 당연히 K8S Release lifecycle을 따라 배포되므로, Provisioner 신규 기능을 사용하기 위해서는 K8S version을 업그레이드해야하는 제약 사항이 있음.

따라서 K8S 개발사는 K8S에 내장된 Provisioner(in-tree)를 모두 삭제하고 별도의 controller Pod를 통해 동적 프로비저닝을 사용할 수 있도록 만들었음. 이 것이 CSI Driver임.

CSI를 사용하면 K8S의 공통화된 CSI 인터페이스를 통해 다양한 프로바이더를 사용할 수 있음.

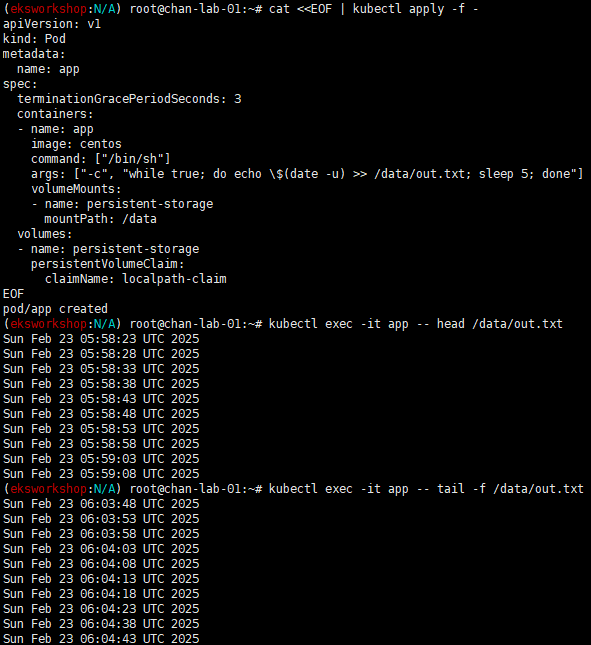

일반적인 CSI Driver 구조는 아래와 같음

AWS EBS CSI Driver도 아래와 같은 구조를 가지는데 오른쪽 StatefulSet 또는 Deployment로 배포된 controller Pod가 AWS API를 사용하여 실제 EBS Volume을 생성하는 역할을 함.

왼쪽 DaemonSet으로 배포된 Node Pod는 AWS API를 사용하여 K8S Node(EC2 Instance)에 EBS Volume을 연결 해줌.

Pod 기본 및 empty 저장소 동작 확인

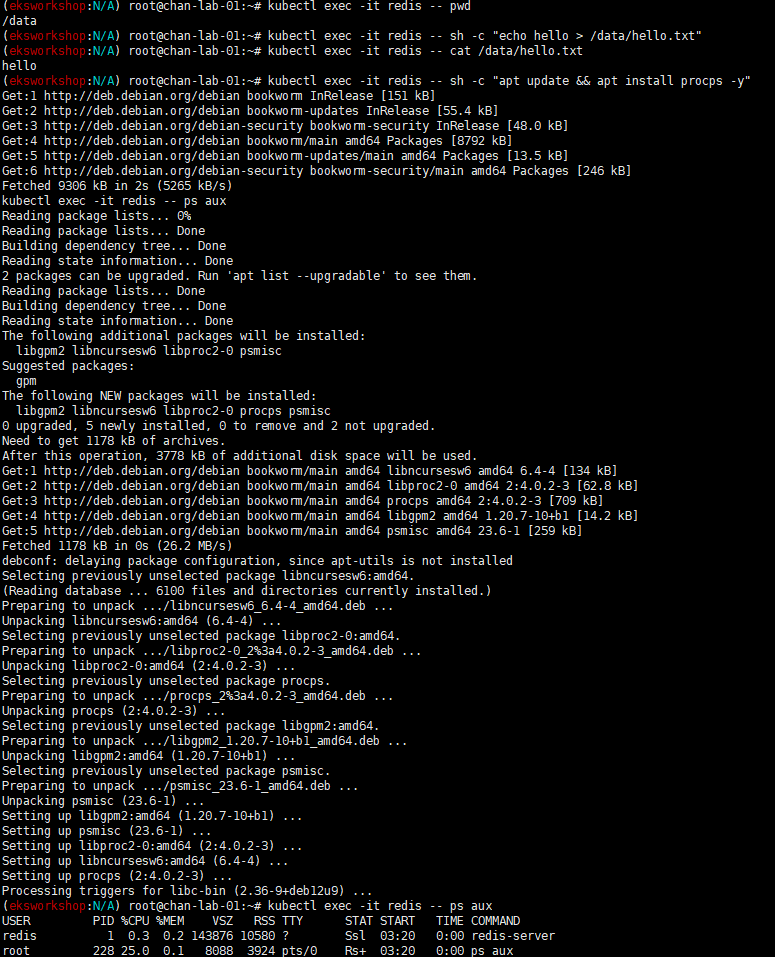

Pod 기본 저장소 동작 확인

# 모니터링

kubectl get pod -w

# redis 파드 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: redis

spec:

terminationGracePeriodSeconds: 0

containers:

- name: redis

image: redis

EOF

# redis 파드 내에 파일 작성

kubectl exec -it redis -- pwd

kubectl exec -it redis -- sh -c "echo hello > /data/hello.txt"

kubectl exec -it redis -- cat /data/hello.txt

# ps 설치

kubectl exec -it redis -- sh -c "apt update && apt install procps -y"

kubectl exec -it redis -- ps aux

# redis 프로세스 강제 종료 : 파드가 어떻게 되나요? hint) restartPolicy

kubectl exec -it redis -- kill 1

kubectl get pod

# redis 파드 내에 파일 확인

kubectl exec -it redis -- cat /data/hello.txt

kubectl exec -it redis -- ls -l /data

# 파드 삭제

kubectl delete pod redis

실습해보면 Pod 삭제 후 다시 올라온 Pod에는 생성한 파일이 없다.

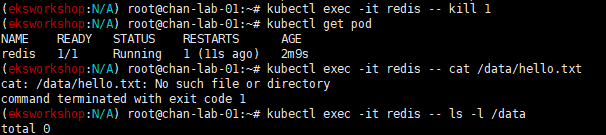

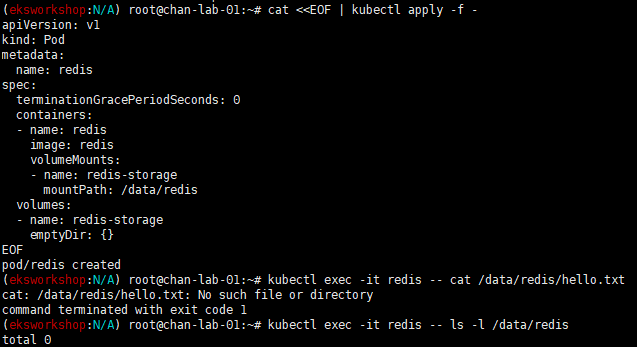

emptyDir 동작 확인

# 모니터링

kubectl get pod -w

# redis 파드 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: redis

spec:

terminationGracePeriodSeconds: 0

containers:

- name: redis

image: redis

volumeMounts:

- name: redis-storage

mountPath: /data/redis

volumes:

- name: redis-storage

emptyDir: {}

EOF

# redis 파드 내에 파일 작성

kubectl exec -it redis -- pwd

kubectl exec -it redis -- sh -c "echo hello > /data/redis/hello.txt"

kubectl exec -it redis -- cat /data/redis/hello.txt

# ps 설치

kubectl exec -it redis -- sh -c "apt update && apt install procps -y"

kubectl exec -it redis -- ps aux

# redis 프로세스 강제 종료 : 파드가 어떻게 되나요? hint) restartPolicy

kubectl exec -it redis -- kill 1

kubectl get pod

# redis 파드 내에 파일 확인

kubectl exec -it redis -- cat /data/redis/hello.txt

kubectl exec -it redis -- ls -l /data/redis

# 파드 삭제 후 파일 확인

kubectl delete pod redis

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: redis

spec:

terminationGracePeriodSeconds: 0

containers:

- name: redis

image: redis

volumeMounts:

- name: redis-storage

mountPath: /data/redis

volumes:

- name: redis-storage

emptyDir: {}

EOF

# redis 파드 내에 파일 확인

kubectl exec -it redis -- cat /data/redis/hello.txt

kubectl exec -it redis -- ls -l /data/redis

# 파드 삭제

kubectl delete pod redis

위와 같이 설정한 후 Pod Kill 했을 경우에는 파일이 남아있지만, Pod를 지우고 재생성하면 파일이 확인되지 않는다.

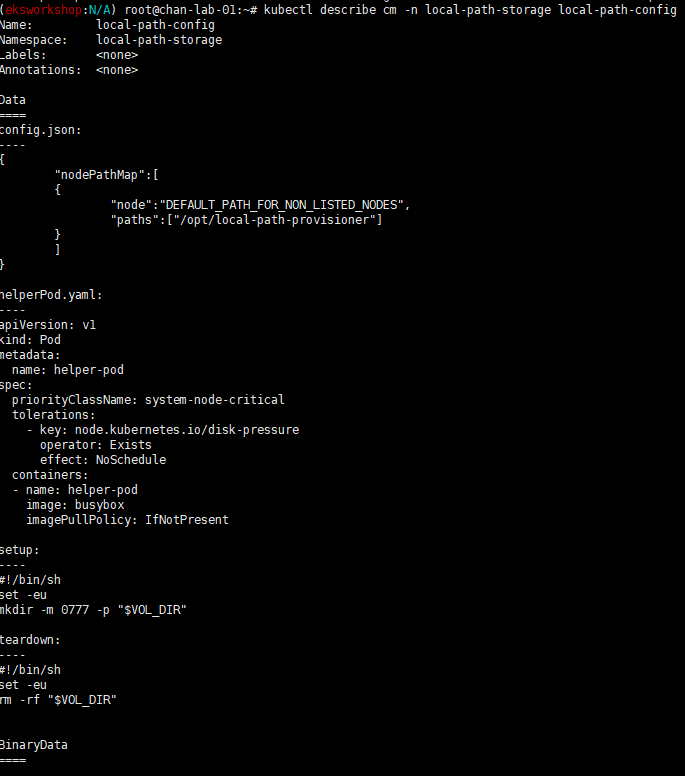

호스트 Path 를 사용하는 PV/PVC : local-path-provisioner 스트리지 클래스 배포

# 배포

kubectl apply -f https://raw.githubusercontent.com/rancher/local-path-provisioner/v0.0.31/deploy/local-path-storage.yaml

# 확인

kubectl get-all -n local-path-storage

kubectl get pod -n local-path-storage -owide

kubectl describe cm -n local-path-storage local-path-config

kubectl get sc

kubectl get sc local-path

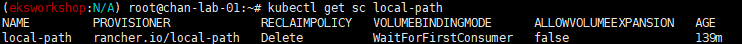

PV/PVC 사용하는 Pod 생성

# PVC 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: localpath-claim

spec:

accessModes:

- ReadWriteOnce

storageClassName: local-path

resources:

requests:

storage: 1Gi

EOF

# PVC 확인

kubectl get pvc

kubectl describe pvc

# 파드 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: app

spec:

terminationGracePeriodSeconds: 3

containers:

- name: app

image: centos

command: ["/bin/sh"]

args: ["-c", "while true; do echo \$(date -u) >> /data/out.txt; sleep 5; done"]

volumeMounts:

- name: persistent-storage

mountPath: /data

volumes:

- name: persistent-storage

persistentVolumeClaim:

claimName: localpath-claim

EOF

# 파드 확인

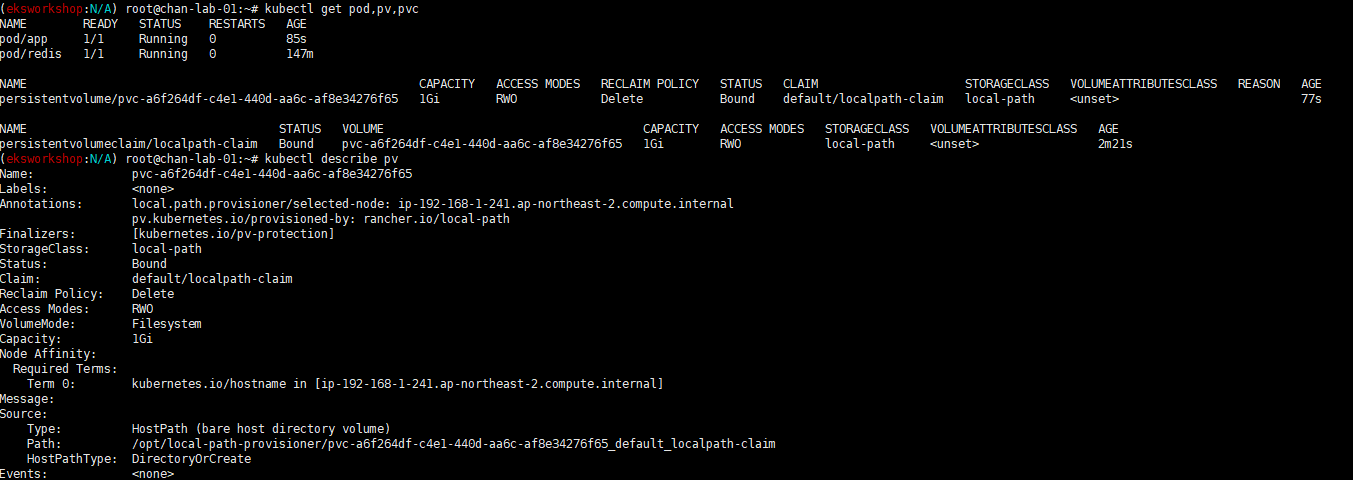

kubectl get pod,pv,pvc

kubectl describe pv # Node Affinity 확인

kubectl exec -it app -- tail -f /data/out.txt

# 워커노드 중 현재 파드가 배포되어 있다만, 아래 경로에 out.txt 파일 존재 확인

for node in $N1 $N2 $N3; do ssh ec2-user@$node tree /opt/local-path-provisioner; done

# 해당 워커노드 자체에서 out.txt 파일 확인

ssh ec2-user@$N1 tail -f /opt/local-path-provisioner/pvc-f1615862-e4cd-47d0-b89c-8d0e99270678_default_localpath-claim/out.txt

Pod 삭제 후 Pod 재생성해서 데이터 유지되는지 확인

# 파드 삭제 후 PV/PVC 확인

kubectl delete pod app

kubectl get pod,pv,pvc

for node in $N1 $N2 $N3; do ssh ec2-user@$node tree /opt/local-path-provisioner; done

# 파드 다시 실행

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: app

spec:

terminationGracePeriodSeconds: 3

containers:

- name: app

image: centos

command: ["/bin/sh"]

args: ["-c", "while true; do echo \$(date -u) >> /data/out.txt; sleep 5; done"]

volumeMounts:

- name: persistent-storage

mountPath: /data

volumes:

- name: persistent-storage

persistentVolumeClaim:

claimName: localpath-claim

EOF

# 확인

kubectl exec -it app -- head /data/out.txt

kubectl exec -it app -- tail -f /data/out.txt

재생성 후 out.txt 파일을 확인하면 데이터가 유지된걸 확인할 수 있다.

AWS EBS Controller

Volume (ebs-csi-controller)

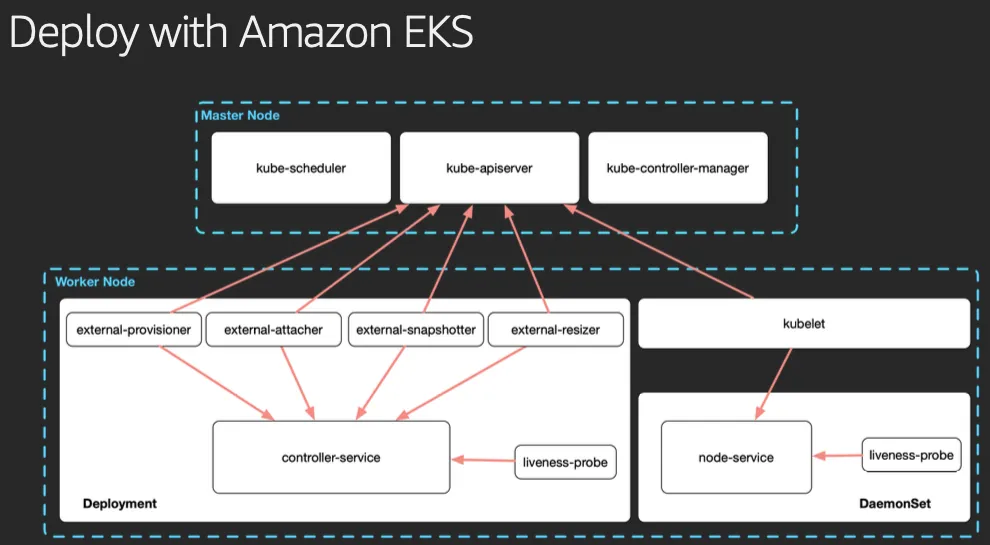

EBS CSI Driver 동작: 볼륨 생성 및 파드에 볼륨 연결

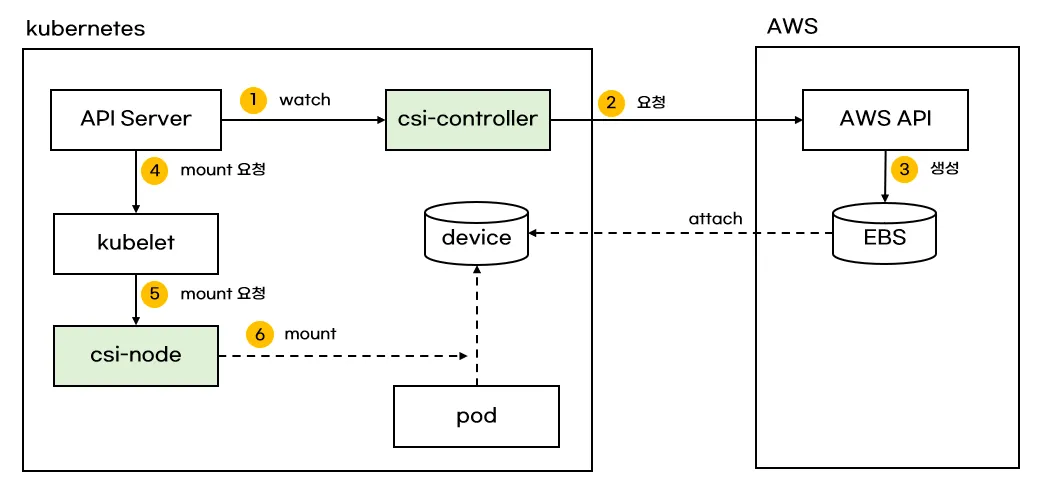

AWS CSI 드라이버는 크게 2가지 구성요소가 있음

AWS API를 호출하면서 AWS 스토리지를 관리하는 CSI-Controller와 kubelet과 상호작용하면서 AWS 스토리지를 pod에 마운트하는 CSI-Node가 있음

persistentvolume, persistentvolumeclaim의 accessModes는 ReadWriteOnce로 설정해야 함

EBS 스토리지 기본 설정이 동일 AZ에 있는 EC2 인스턴스(에 배포된 파드)에 연결해야 함

# aws-ebs-csi-driver 전체 버전 정보와 기본 설치 버전(True) 정보 확인

aws eks describe-addon-versions \

--addon-name aws-ebs-csi-driver \

--kubernetes-version 1.31 \

--query "addons[].addonVersions[].[addonVersion, compatibilities[].defaultVersion]" \

--output text

# ISRA 설정 : AWS관리형 정책 AmazonEBSCSIDriverPolicy 사용

eksctl create iamserviceaccount \

--name ebs-csi-controller-sa \

--namespace kube-system \

--cluster ${CLUSTER_NAME} \

--attach-policy-arn arn:aws:iam::aws:policy/service-role/AmazonEBSCSIDriverPolicy \

--approve \

--role-only \

--role-name AmazonEKS_EBS_CSI_DriverRole

# ISRA 확인

eksctl get iamserviceaccount --cluster ${CLUSTER_NAME}

NAMESPACE NAME ROLE ARN

kube-system ebs-csi-controller-sa arn:aws:iam::911283464785:role/AmazonEKS_EBS_CSI_DriverRole

...

# Amazon EBS CSI driver addon 배포(설치)

export ACCOUNT_ID=$(aws sts get-caller-identity --query 'Account' --output text)

eksctl create addon --name aws-ebs-csi-driver --cluster ${CLUSTER_NAME} --service-account-role-arn arn:aws:iam::${ACCOUNT_ID}:role/AmazonEKS_EBS_CSI_DriverRole --force

kubectl get sa -n kube-system ebs-csi-controller-sa -o yaml | head -5

# 확인

eksctl get addon --cluster ${CLUSTER_NAME}

kubectl get deploy,ds -l=app.kubernetes.io/name=aws-ebs-csi-driver -n kube-system

kubectl get pod -n kube-system -l 'app in (ebs-csi-controller,ebs-csi-node)'

kubectl get pod -n kube-system -l app.kubernetes.io/component=csi-driver

# ebs-csi-controller 파드에 6개 컨테이너 확인

kubectl get pod -n kube-system -l app=ebs-csi-controller -o jsonpath='{.items[0].spec.containers[*].name}' ; echo

ebs-plugin csi-provisioner csi-attacher csi-snapshotter csi-resizer liveness-probe

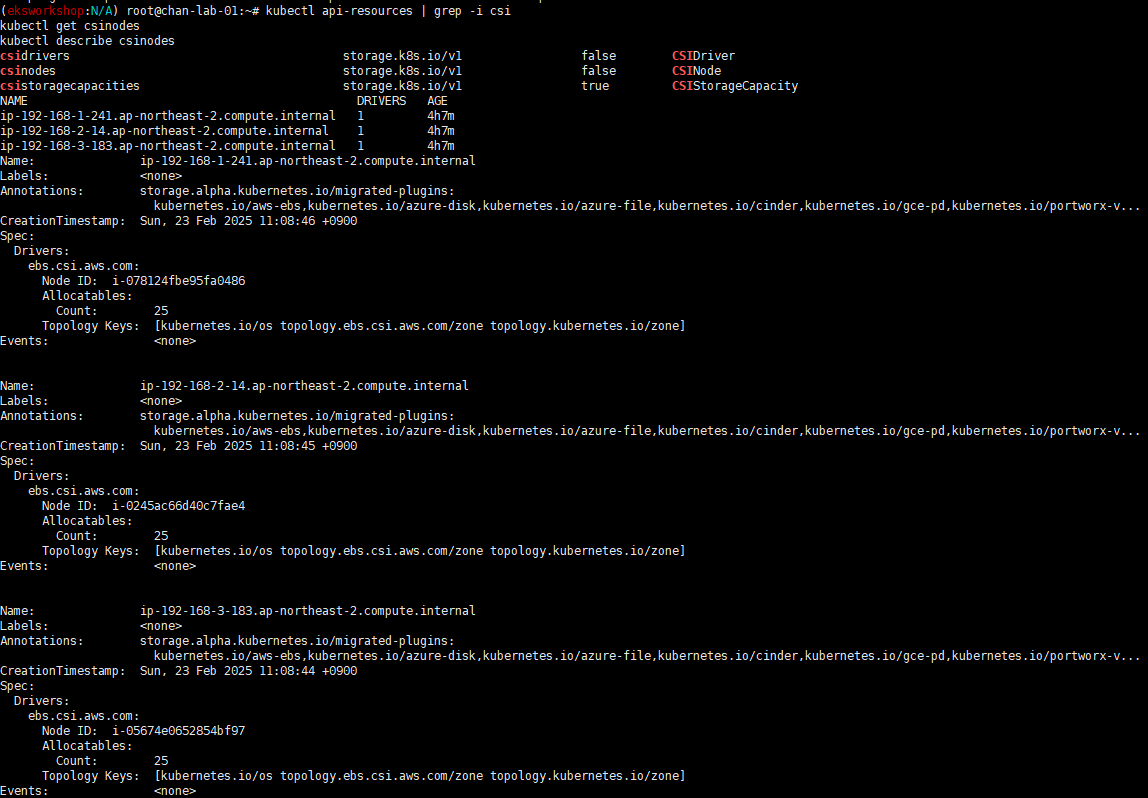

# csinodes 확인

kubectl api-resources | grep -i csi

kubectl get csinodes

kubectl describe csinodes

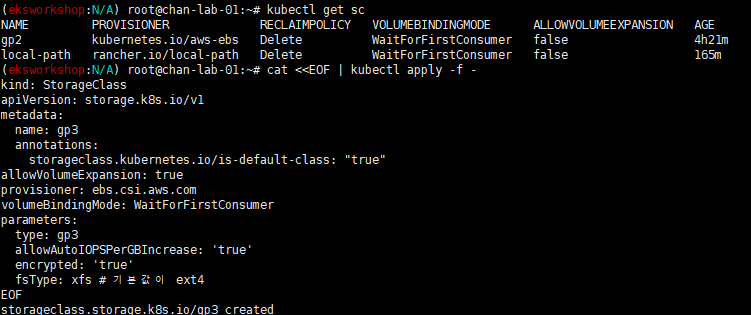

gp3 스토리지 클래스 생성

AWS EBS 스토리지 클래스 파라미터 gp3로 생성

# gp3 스토리지 클래스 생성

kubectl get sc

cat <<EOF | kubectl apply -f -

kind: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: gp3

annotations:

storageclass.kubernetes.io/is-default-class: "true"

allowVolumeExpansion: true

provisioner: ebs.csi.aws.com

volumeBindingMode: WaitForFirstConsumer

parameters:

type: gp3

allowAutoIOPSPerGBIncrease: 'true'

encrypted: 'true'

fsType: xfs # 기본값이 ext4

EOF

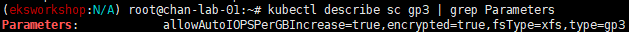

kubectl get sc

kubectl describe sc gp3 | grep Parameters

- VolumeBindingMode: 볼륨 바인딩과 동적 프로비저닝의 시작 시기를 제어, 설정돼있지 않으면 Immediate 모드가 기본으로 사용됨

- Immediate 모드는 퍼시스턴트볼륨클레임이 생성되면 볼륨 바인딩과 동적 프로비저닝이 즉시 발생하는 것을 나타냄. 토폴로지 제약이 있고 클러스터의 모든 노드에서 전역적으로 접근할 수 없는 스토리지 백엔드의 경우, 파드의 스케줄링 요구 사항에 대한 파악없이 퍼시스턴트 볼륨이 바인딩되거나 프로비저닝되며 이로 인해 스케줄되지 않은 파드가 발생할 수 있음

- WaitForFirstConsumer 모드를 지정해서 이 문제를 해결할 수 있는데 이 모드는 퍼시스턴트볼륨클레임을 사용하는 파드가 생성될 때까지 퍼시스턴트볼륨의 바인딩과 프로비저닝을 지연시킴. 퍼시스턴트볼륨은 파드의 스케줄링 제약 조건에 의해 지정된 토폴로지에 따라 선택되거나 프로비저닝 됨. 여기에는 리소스 요구 사항, 노드 셀렉터, 파드 어피니티(affinity)와 안티-어피니티(anti-affinity) 그리고 테인트(taint)와 톨러레이션(toleration)이 포함됨.

PVC/PV 파드 테스트

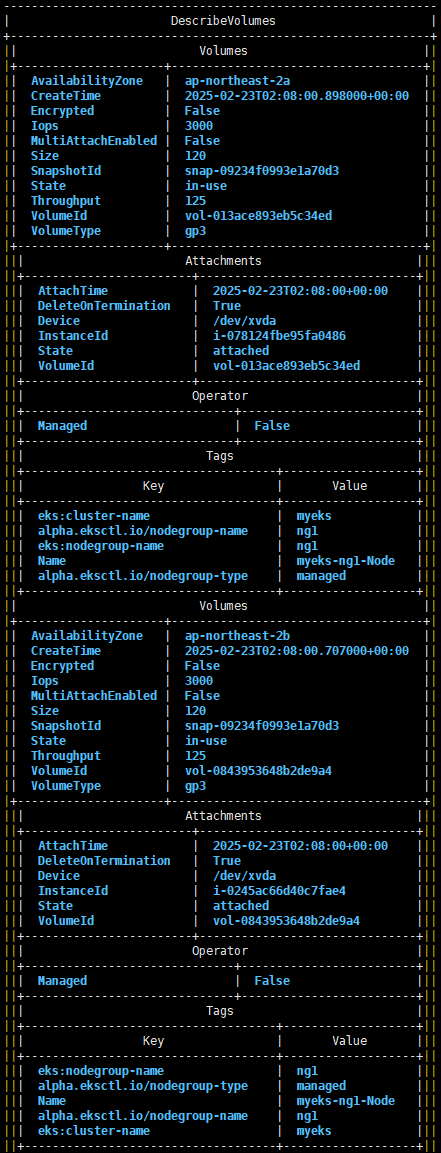

# 워커노드의 EBS 볼륨 확인 : tag(키/값) 필터링 - 링크

aws ec2 describe-volumes --filters Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node --output table

aws ec2 describe-volumes --filters Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node --query "Volumes[*].Attachments" | jq

aws ec2 describe-volumes --filters Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node --query "Volumes[*].{ID:VolumeId,Tag:Tags}" | jq

aws ec2 describe-volumes --filters Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node --query "Volumes[].[VolumeId, VolumeType, Attachments[].[InstanceId, State][]][]" | jq

aws ec2 describe-volumes --filters Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node --query "Volumes[].{VolumeId: VolumeId, VolumeType: VolumeType, InstanceId: Attachments[0].InstanceId, State: Attachments[0].State}" | jq

# 워커노드에서 파드에 추가한 EBS 볼륨 확인

aws ec2 describe-volumes --filters Name=tag:ebs.csi.aws.com/cluster,Values=true --output table

aws ec2 describe-volumes --filters Name=tag:ebs.csi.aws.com/cluster,Values=true --query "Volumes[*].{ID:VolumeId,Tag:Tags}" | jq

aws ec2 describe-volumes --filters Name=tag:ebs.csi.aws.com/cluster,Values=true --query "Volumes[].{VolumeId: VolumeId, VolumeType: VolumeType, InstanceId: Attachments[0].InstanceId, State: Attachments[0].State}" | jq

# 워커노드에서 파드에 추가한 EBS 볼륨 모니터링

while true; do aws ec2 describe-volumes --filters Name=tag:ebs.csi.aws.com/cluster,Values=true --query "Volumes[].{VolumeId: VolumeId, VolumeType: VolumeType, InstanceId: Attachments[0].InstanceId, State: Attachments[0].State}" --output text; date; sleep 1; done

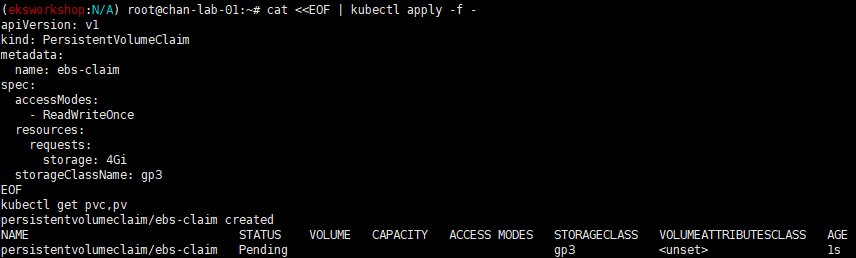

# PVC 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: ebs-claim

spec:

accessModes:

- ReadWriteOnce

resources:

requests:

storage: 4Gi

storageClassName: gp3

EOF

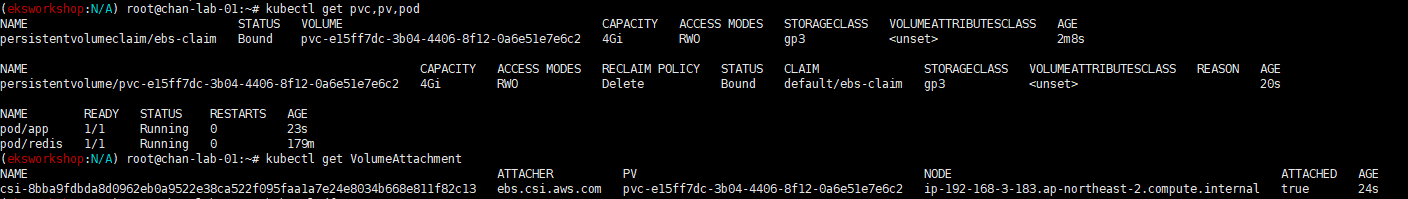

kubectl get pvc,pv

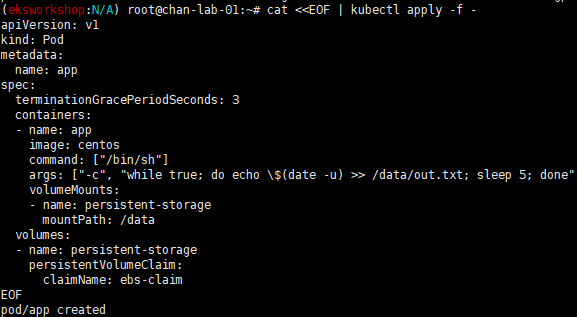

# 파드 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: app

spec:

terminationGracePeriodSeconds: 3

containers:

- name: app

image: centos

command: ["/bin/sh"]

args: ["-c", "while true; do echo \$(date -u) >> /data/out.txt; sleep 5; done"]

volumeMounts:

- name: persistent-storage

mountPath: /data

volumes:

- name: persistent-storage

persistentVolumeClaim:

claimName: ebs-claim

EOF

# PVC, 파드 확인

kubectl get pvc,pv,pod

kubectl get VolumeAttachment

kubectl df-pv

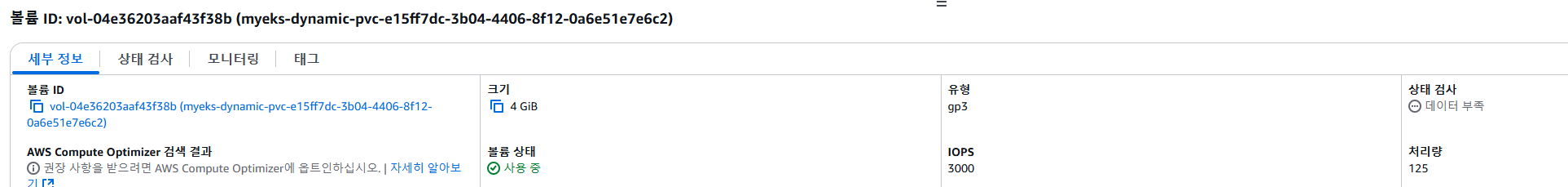

# 추가된 EBS 볼륨 상세 정보 확인 : AWS 관리콘솔 EC2(EBS)에서 확인

aws ec2 describe-volumes --volume-ids $(kubectl get pv -o jsonpath="{.items[0].spec.csi.volumeHandle}") | jq

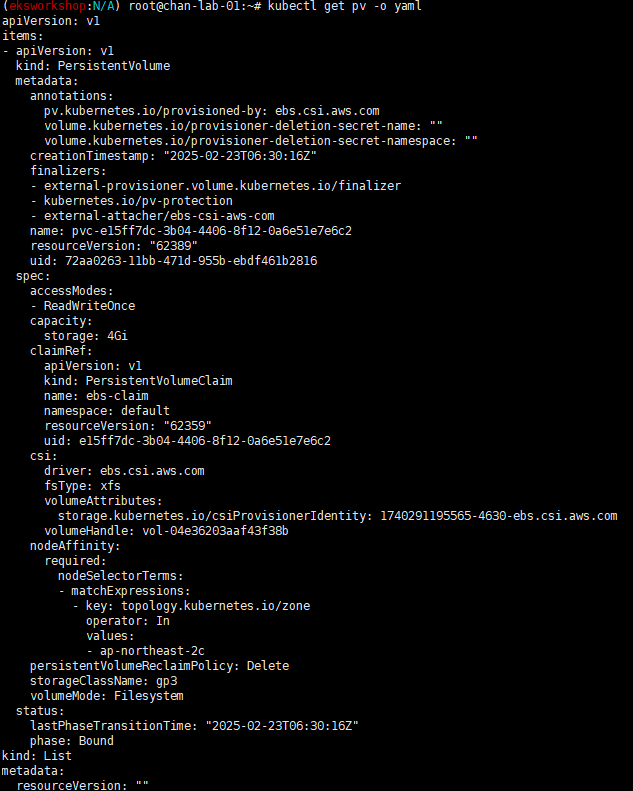

# PV 상세 확인 : nodeAffinity 내용의 의미는?

kubectl get pv -o yaml

...

nodeAffinity:

required:

nodeSelectorTerms:

- matchExpressions:

- key: topology.ebs.csi.aws.com/zone

operator: In

values:

- ap-northeast-2b

...

kubectl get node --label-columns=topology.ebs.csi.aws.com/zone,topology.k8s.aws/zone-id

kubectl describe node

# 파일 내용 추가 저장 확인

kubectl exec app -- tail -f /data/out.txt

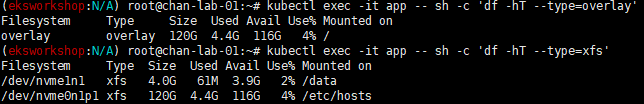

## 파드 내에서 볼륨 정보 확인

kubectl exec -it app -- sh -c 'df -hT --type=overlay'

kubectl exec -it app -- sh -c 'df -hT --type=xfs'

- nodeAffinity: Persistent Volume이 특정 노드에서만 사용 가능하도록 제약을 설정. 지정된 조건을 만족하는 노드에서만 PV를 사용할 수 있음

- required: 노드는 반드시 명시된 조건을 만족해야만 PV를 사용할 수 있음

- nodeSelectorTerms: 조건 리스트. 리스트 내의 하나 이상의 조건(OR 조건)을 만족하면 해당 노드는 매칭됨

- matchExpressions: 각 matchExpressions 블록은 특정 조건(AND 조건)을 정의. 블록 내의 모든 조건을 만족해야 매칭됨

- key: topology.kubernetes.io/zone: 노드가 속한 가용 영역(availability zone)을 나타내는 Kubernetes 표준 레이블

- operator: In: 조건 평가 방식

- In: 노드의 레이블 값이 values에 정의된 값 중 하나와 일치해야 함

- values: - ap-northeast-2c: 노드가 ap-northeast-2c 가용 영역에 있어야 한다는 것을 의미함

- matchExpressions: 각 matchExpressions 블록은 특정 조건(AND 조건)을 정의. 블록 내의 모든 조건을 만족해야 매칭됨

- nodeSelectorTerms: 조건 리스트. 리스트 내의 하나 이상의 조건(OR 조건)을 만족하면 해당 노드는 매칭됨

AWS Volume SnapShots Controller

Volumesnapshots 컨트롤러 설치

# Install Snapshot CRDs

kubectl apply -f https://raw.githubusercontent.com/kubernetes-csi/external-snapshotter/master/client/config/crd/snapshot.storage.k8s.io_volumesnapshots.yaml

kubectl apply -f https://raw.githubusercontent.com/kubernetes-csi/external-snapshotter/master/client/config/crd/snapshot.storage.k8s.io_volumesnapshotclasses.yaml

kubectl apply -f https://raw.githubusercontent.com/kubernetes-csi/external-snapshotter/master/client/config/crd/snapshot.storage.k8s.io_volumesnapshotcontents.yaml

kubectl get crd | grep snapshot

kubectl api-resources | grep snapshot

# Install Common Snapshot Controller

kubectl apply -f https://raw.githubusercontent.com/kubernetes-csi/external-snapshotter/master/deploy/kubernetes/snapshot-controller/rbac-snapshot-controller.yaml

kubectl apply -f https://raw.githubusercontent.com/kubernetes-csi/external-snapshotter/master/deploy/kubernetes/snapshot-controller/setup-snapshot-controller.yaml

kubectl get deploy -n kube-system snapshot-controller

kubectl get pod -n kube-system

# Install Snapshotclass

kubectl apply -f https://raw.githubusercontent.com/kubernetes-sigs/aws-ebs-csi-driver/master/examples/kubernetes/snapshot/manifests/classes/snapshotclass.yaml

kubectl get vsclass # 혹은 volumesnapshotclasses

kubectl describe vsclass

테스트 PVC/Pod 생성

# PVC 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: ebs-claim

spec:

accessModes:

- ReadWriteOnce

resources:

requests:

storage: 4Gi

storageClassName: gp3

EOF

kubectl get pvc,pv

# 파드 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: app

spec:

terminationGracePeriodSeconds: 3

containers:

- name: app

image: centos

command: ["/bin/sh"]

args: ["-c", "while true; do echo \$(date -u) >> /data/out.txt; sleep 5; done"]

volumeMounts:

- name: persistent-storage

mountPath: /data

volumes:

- name: persistent-storage

persistentVolumeClaim:

claimName: ebs-claim

EOF

# 파일 내용 추가 저장 확인

kubectl exec app -- tail -f /data/out.txt

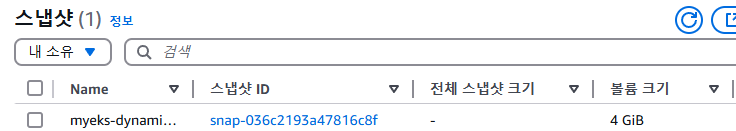

# VolumeSnapshot 생성 : Create a VolumeSnapshot referencing the PersistentVolumeClaim name

# AWS 관리 콘솔 EBS 스냅샷 확인

cat <<EOF | kubectl apply -f -

apiVersion: snapshot.storage.k8s.io/v1

kind: VolumeSnapshot

metadata:

name: ebs-volume-snapshot

spec:

volumeSnapshotClassName: csi-aws-vsc

source:

persistentVolumeClaimName: ebs-claim

EOF

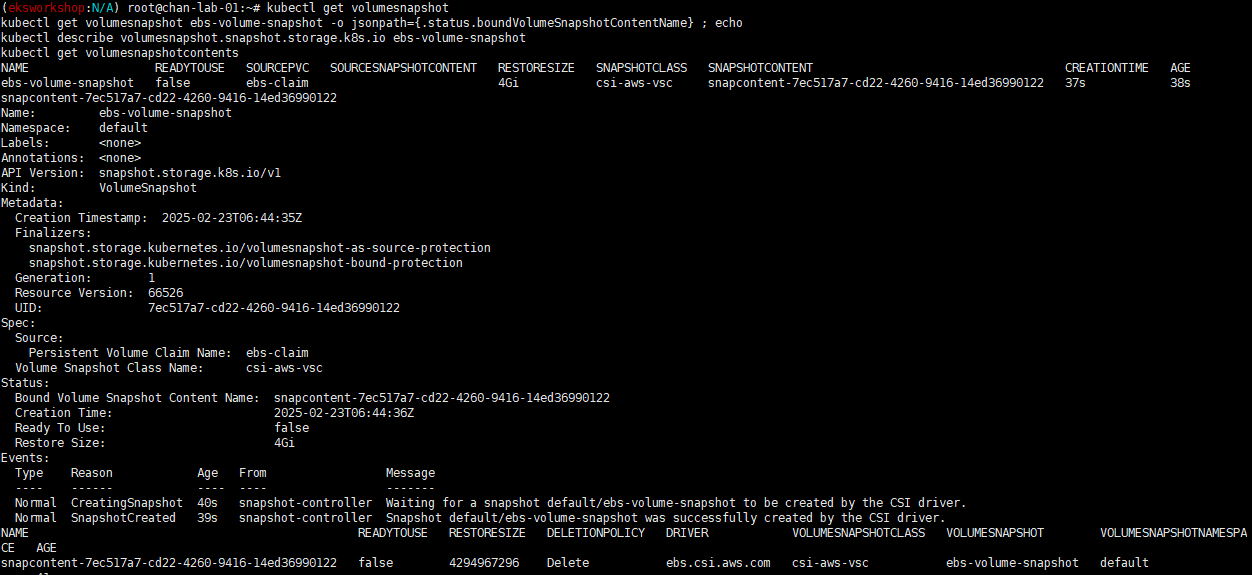

# VolumeSnapshot 확인

kubectl get volumesnapshot

kubectl get volumesnapshot ebs-volume-snapshot -o jsonpath={.status.boundVolumeSnapshotContentName} ; echo

kubectl describe volumesnapshot.snapshot.storage.k8s.io ebs-volume-snapshot

kubectl get volumesnapshotcontents

# VolumeSnapshot ID 확인

kubectl get volumesnapshotcontents -o jsonpath='{.items[*].status.snapshotHandle}' ; echo

# AWS EBS 스냅샷 확인

aws ec2 describe-snapshots --owner-ids self | jq

aws ec2 describe-snapshots --owner-ids self --query 'Snapshots[]' --output table

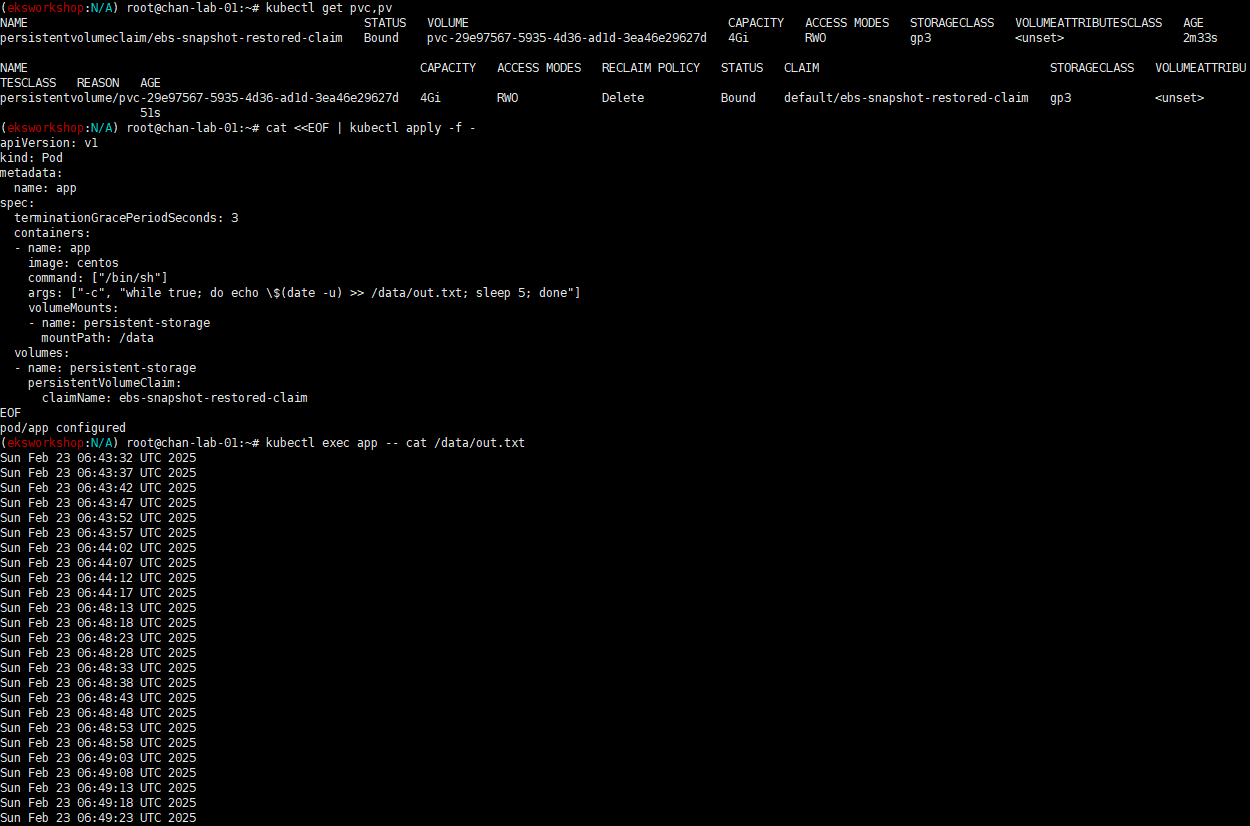

# app & pvc 제거 : 강제로 장애 재현

kubectl delete pod app && kubectl delete pvc ebs-claim

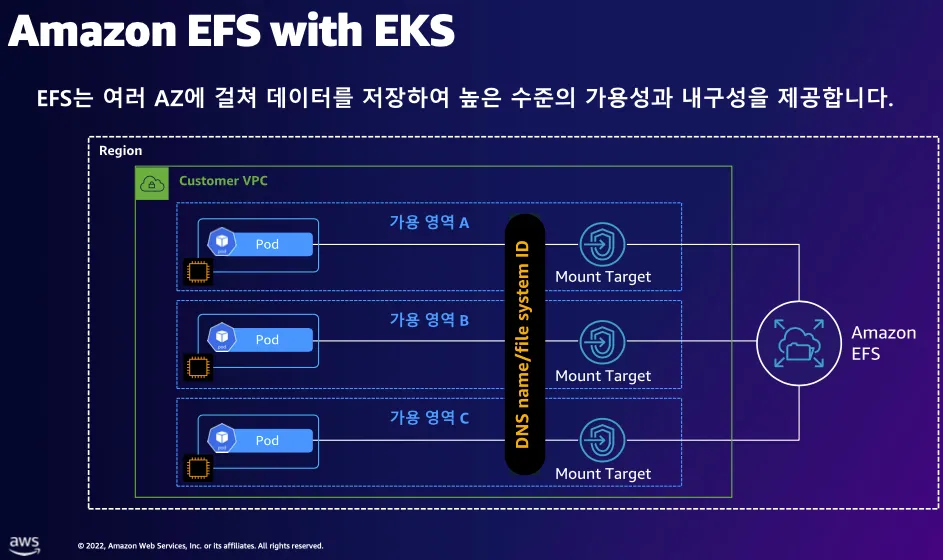

AWS EFS Controller

구성 아키텍처

# EFS 정보 확인

aws efs describe-file-systems --query "FileSystems[*].FileSystemId" --output text

# 아래는 aws-efs-csi-driver 전체 버전 정보와 기본 설치 버전(True) 정보 확인

aws eks describe-addon-versions \

--addon-name aws-efs-csi-driver \

--kubernetes-version 1.31 \

--query "addons[].addonVersions[].[addonVersion, compatibilities[].defaultVersion]" \

--output text

# ISRA 설정 : 고객관리형 정책 AmazonEKS_EFS_CSI_Driver_Policy 사용

eksctl create iamserviceaccount \

--name efs-csi-controller-sa \

--namespace kube-system \

--cluster ${CLUSTER_NAME} \

--attach-policy-arn arn:aws:iam::aws:policy/service-role/AmazonEFSCSIDriverPolicy \

--approve \

--role-only \

--role-name AmazonEKS_EFS_CSI_DriverRole

# ISRA 확인

eksctl get iamserviceaccount --cluster ${CLUSTER_NAME}

# Amazon EFS CSI driver addon 배포(설치)

export ACCOUNT_ID=$(aws sts get-caller-identity --query 'Account' --output text)

eksctl create addon --name aws-efs-csi-driver --cluster ${CLUSTER_NAME} --service-account-role-arn arn:aws:iam::${ACCOUNT_ID}:role/AmazonEKS_EFS_CSI_DriverRole --force

kubectl get sa -n kube-system efs-csi-controller-sa -o yaml | head -5

# 확인

eksctl get addon --cluster ${CLUSTER_NAME}

kubectl get pod -n kube-system -l "app.kubernetes.io/name=aws-efs-csi-driver,app.kubernetes.io/instance=aws-efs-csi-driver"

kubectl get pod -n kube-system -l app=efs-csi-controller -o jsonpath='{.items[0].spec.containers[*].name}' ; echo

kubectl get csidrivers efs.csi.aws.com -o yaml

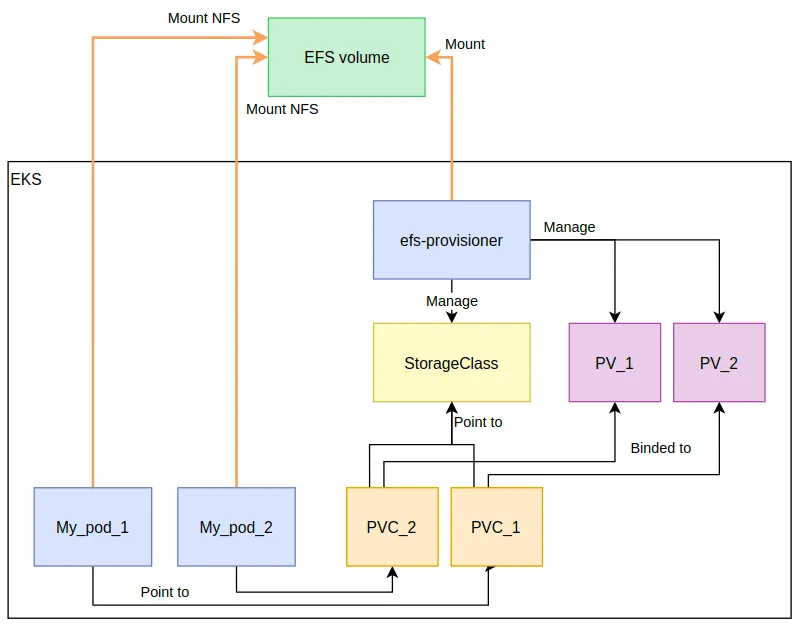

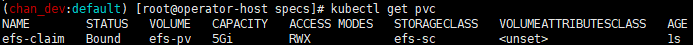

EFS 파일시스템을 파드가 사용하게 설정

# 모니터링

watch 'kubectl get sc efs-sc; echo; kubectl get pv,pvc,pod'

# [운영 서버 EC2]

# 실습 코드 clone

git clone https://github.com/kubernetes-sigs/aws-efs-csi-driver.git /root/efs-csi

cd /root/efs-csi/examples/kubernetes/multiple_pods/specs && tree

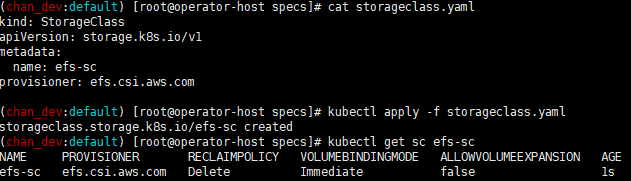

# EFS 스토리지클래스 생성 및 확인

cat storageclass.yaml

kubectl apply -f storageclass.yaml

kubectl get sc efs-sc

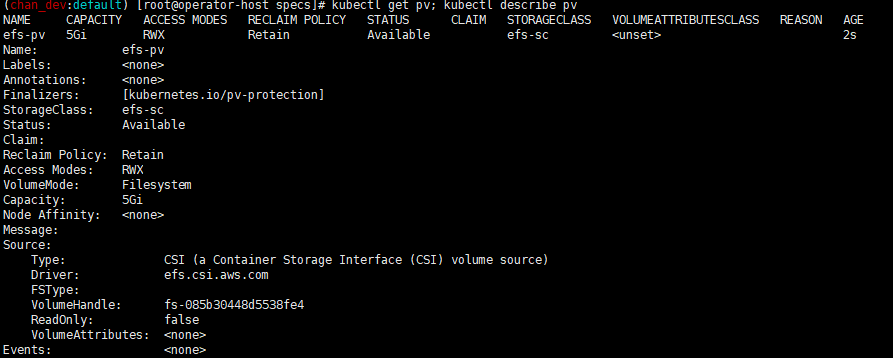

# PV 생성 및 확인 : volumeHandle을 자신의 EFS 파일시스템ID로 변경

EfsFsId=$(aws efs describe-file-systems --query "FileSystems[*].FileSystemId" --output text)

sed -i "s/fs-4af69aab/$EfsFsId/g" pv.yaml

cat pv.yaml

# PVC 생성 및 확인

cat claim.yaml

kubectl apply -f claim.yaml

kubectl get pvc

# 파드 생성 및 연동 : 파드 내에 /data 데이터는 EFS를 사용

cat pod1.yaml pod2.yaml

kubectl apply -f pod1.yaml,pod2.yaml

kubectl df-pv

# 파드 정보 확인

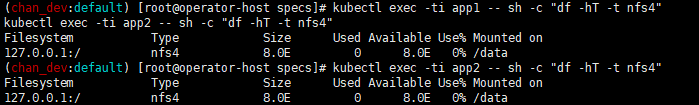

kubectl get pods

kubectl exec -ti app1 -- sh -c "df -hT -t nfs4"

kubectl exec -ti app2 -- sh -c "df -hT -t nfs4"

# 공유 저장소 저장 동작 확인

tree /mnt/myefs # 운영서버 EC2 에서 확인

tail -f /mnt/myefs/out1.txt # 운영서버 EC2 에서 확인

tail -f /mnt/myefs/out2.txt # 운영서버 EC2 에서 확인

kubectl exec -ti app1 -- tail -f /data/out1.txt

kubectl exec -ti app2 -- tail -f /data/out2.txt

EFS 파일시스템을 다수의 파드에서 사용하게 설정

Fargate 노드는 현재 미지원한다.

# 모니터링

watch 'kubectl get sc efs-sc; echo; kubectl get pv,pvc,pod'

# [운영 서버 EC2]

# EFS 스토리지클래스 생성 및 확인

curl -s -O https://raw.githubusercontent.com/kubernetes-sigs/aws-efs-csi-driver/master/examples/kubernetes/dynamic_provisioning/specs/storageclass.yaml

cat storageclass.yaml

sed -i "s/fs-92107410/$EfsFsId/g" storageclass.yaml

kubectl apply -f storageclass.yaml

kubectl get sc efs-sc

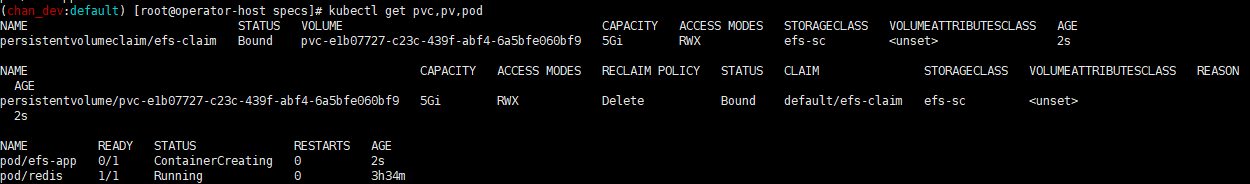

# PVC/파드 생성 및 확인

curl -s -O https://raw.githubusercontent.com/kubernetes-sigs/aws-efs-csi-driver/master/examples/kubernetes/dynamic_provisioning/specs/pod.yaml

cat pod.yaml

kubectl apply -f pod.yaml

kubectl get pvc,pv,pod

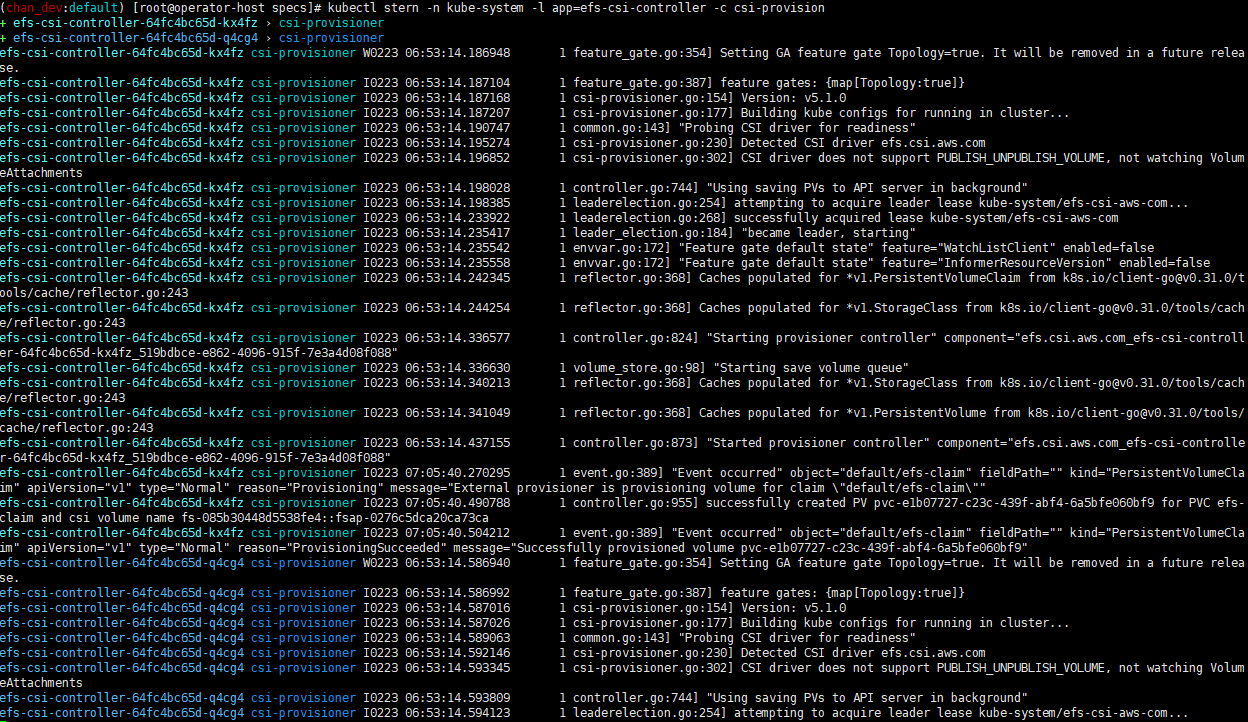

# PVC/PV 생성 로그 확인

kubectl krew install stern

kubectl stern -n kube-system -l app=efs-csi-controller -c csi-provisioner

혹은

kubectl logs -n kube-system -l app=efs-csi-controller -c csi-provisioner -f

# 파드 정보 확인

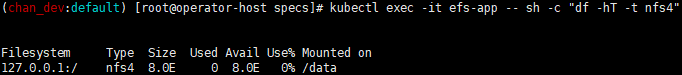

kubectl exec -it efs-app -- sh -c "df -hT -t nfs4"

# 공유 저장소 저장 동작 확인

tree /mnt/myefs # 운영서버 EC2 에서 확인

kubectl exec efs-app -- bash -c "cat /data/out"

kubectl exec efs-app -- bash -c "ls -l /data/out"

kubectl exec efs-app -- bash -c "stat /data/"

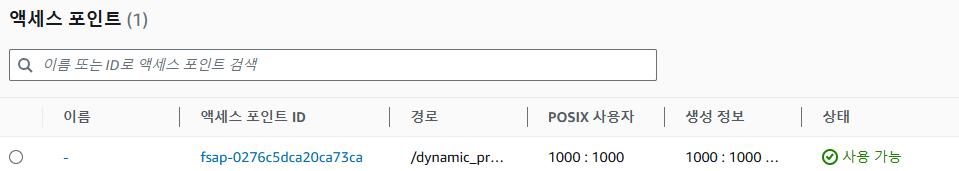

EFS Access Point

EFS Access Point는 EFS의 특정 부분을 격리하고, UID/GID를 강제하여 보안성을 높임

여러 팀, 여러 애플리케이션이 같은 EFS를 사용할 때 Access Point를 활용하면 보안과 관리가 용이함

| 특징 | 일반적인 EFS 사용 | EFS Access Point 사용 |

| 접근 방식 | 파일 시스템 전체 접근 | Access Point별 특정 디렉터리 접근 |

| 보안 | IAM으로 파일 시스템 전체 권한 관리 | Access Point별 IAM 권한 관리로 보안 강화 |

| 관리 | 여러 사용자 권한 관리 부담 | Access Point별 권한 관리로 용이 |

| 사용 사례 | 단순 환경, 파일 시스템 전체 접근 필요 | 다중 사용자 환경, 애플리케이션별 접근 제한 필요 |

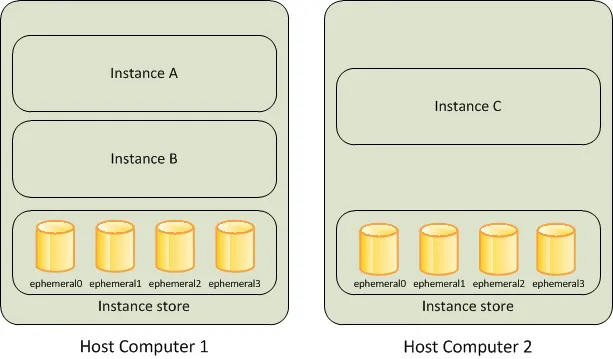

EKS Persistent Volumes for Instance Store & Add NodeGroup

Instance Store가 포함된 EC2 인스턴스를 사용하면 로컬 디스크를 Persistent Volume(PV)으로 설정하여 사용할 수 있음

Instance Store는 EC2 인스턴스에 직접 연결된 고속 NVMe SSD, HDD임

EBS와 달리 인스턴스가 종료되면 데이터 손실 발생

데이터 손실 : 기본 디스크 드라이브 오류, 인스턴스가 중지됨, 인스턴스가 최대 절전 모드로 전환됨, 인스턴스가 종료됨

# 인스턴스 스토어 볼륨이 있는 c5 모든 타입의 스토리지 크기

aws ec2 describe-instance-types \

--filters "Name=instance-type,Values=c5*" "Name=instance-storage-supported,Values=true" \

--query "InstanceTypes[].[InstanceType, InstanceStorageInfo.TotalSizeInGB]" \

--output table

# 신규 노드 그룹 생성 전 정보 확인

eksctl create nodegroup --help

eksctl create nodegroup -c $CLUSTER_NAME -r ap-northeast-2 --subnet-ids "$PubSubnet1","$PubSubnet2","$PubSubnet3" --ssh-access \

-n ng2 -t c5d.large -N 1 -m 1 -M 1 --node-volume-size=30 --node-labels disk=instancestore --max-pods-per-node 100 --dry-run > myng2.yaml

cat <<EOT > nvme.yaml

preBootstrapCommands:

- |

# Install Tools

yum install nvme-cli links tree jq tcpdump sysstat -y

# Filesystem & Mount

mkfs -t xfs /dev/nvme1n1

mkdir /data

mount /dev/nvme1n1 /data

# Get disk UUID

uuid=\$(blkid -o value -s UUID mount /dev/nvme1n1 /data)

# Mount the disk during a reboot

echo /dev/nvme1n1 /data xfs defaults,noatime 0 2 >> /etc/fstab

EOT

sed -i -n -e '/volumeType/r nvme.yaml' -e '1,$p' myng2.yaml

#

export PubSubnet1=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet1" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet2=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet2" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet3=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet3" --query "Subnets[0].[SubnetId]" --output text)

echo $PubSubnet1 $PubSubnet2 $PubSubnet3

#

SSHKEYNAME=<MY KEY>인스턴스 스토어는 EC2 스토리지(EBS) 정보에 출력되지는 않음

Yaml 파일 작성

cat << EOF > myng2.yaml

apiVersion: eksctl.io/v1alpha5

kind: ClusterConfig

metadata:

name: myeks

region: ap-northeast-2

version: "1.31"

managedNodeGroups:

- amiFamily: AmazonLinux2

desiredCapacity: 1

instanceType: c5d.large

labels:

alpha.eksctl.io/cluster-name: myeks

alpha.eksctl.io/nodegroup-name: ng2

disk: instancestore

maxPodsPerNode: 110

maxSize: 1

minSize: 1

name: ng2

ssh:

allow: true

publicKeyName: $SSHKEYNAME

subnets:

- $PubSubnet1

- $PubSubnet2

- $PubSubnet3

tags:

alpha.eksctl.io/nodegroup-name: ng2

alpha.eksctl.io/nodegroup-type: managed

volumeIOPS: 3000

volumeSize: 30

volumeThroughput: 125

volumeType: gp3

preBootstrapCommands:

- |

# Install Tools

yum install nvme-cli links tree jq tcpdump sysstat -y

# Filesystem & Mount

mkfs -t xfs /dev/nvme1n1

mkdir /data

mount /dev/nvme1n1 /data

# Get disk UUID

uuid=\$(blkid -o value -s UUID mount /dev/nvme1n1 /data)

# Mount the disk during a reboot

echo /dev/nvme1n1 /data xfs defaults,noatime 0 2 >> /etc/fstab

EOF

생성 실습

# 신규 노드 그룹 생성

eksctl create nodegroup -f myng2.yaml

# 확인

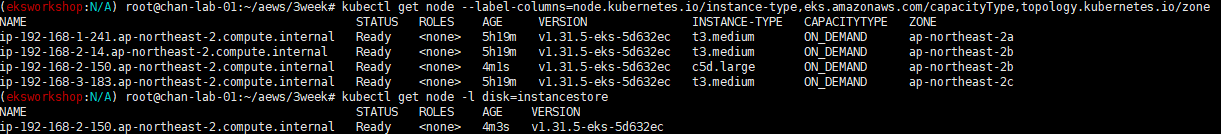

kubectl get node --label-columns=node.kubernetes.io/instance-type,eks.amazonaws.com/capacityType,topology.kubernetes.io/zone

kubectl get node -l disk=instancestore

# ng2 노드 그룹 *ng2-remoteAccess* 포함된 보안그룹 ID

aws ec2 describe-security-groups --filters "Name=group-name,Values=*ng2-remoteAccess*" | jq

export NG2SGID=$(aws ec2 describe-security-groups --filters "Name=group-name,Values=*ng2-remoteAccess*" --query 'SecurityGroups[*].GroupId' --output text)

aws ec2 authorize-security-group-ingress --group-id $NG2SGID --protocol '-1' --cidr $(curl -s ipinfo.io/ip)/32

aws ec2 authorize-security-group-ingress --group-id $NG2SGID --protocol '-1' --cidr 172.20.1.100/32

# 워커 노드 SSH 접속

N4=<각자 자신의 워커 노드4번 공인 IP 지정>

ssh ec2-user@$N4 hostname

# 확인

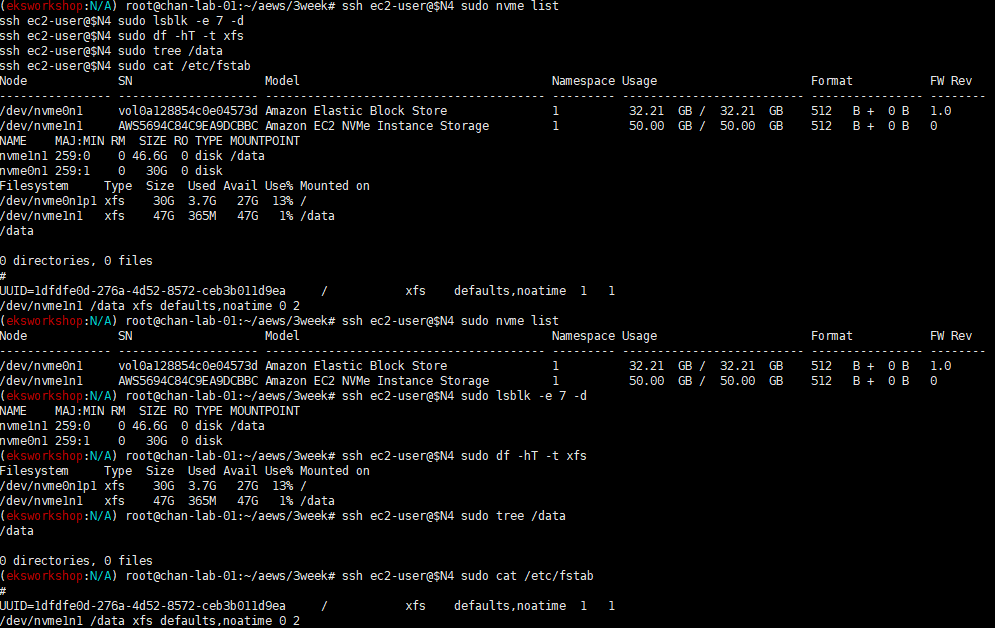

ssh ec2-user@$N4 sudo nvme list

ssh ec2-user@$N4 sudo lsblk -e 7 -d

ssh ec2-user@$N4 sudo df -hT -t xfs

ssh ec2-user@$N4 sudo tree /data

ssh ec2-user@$N4 sudo cat /etc/fstab

# (옵션) max-pod 확인

kubectl describe node -l disk=instancestore | grep Allocatable: -A7

# (옵션) kubelet 데몬 파라미터 확인 : --max-pods=29 --max-pods=110

ssh ec2-user@$N4 cat /etc/eks/bootstrap.sh

ssh ec2-user@$N4 sudo ps -ef | grep kubelet

자원 삭제

eksctl delete cluster --name $CLUSTER_NAME

aws cloudformation delete-stack --stack-name myeks

vi ~/.bashrc에서 설정한 환경 변수 삭제'k8s > AWS EKS' 카테고리의 다른 글

| [AWS] EKS AutoScaling (0) | 2025.03.08 |

|---|---|

| [AWS] EKS Observability (0) | 2025.03.01 |

| [AWS] EKS Networking (0) | 2025.02.16 |

| [AWS]EKS Cluster Endpoint 정리 (0) | 2025.02.07 |

| [AWS] EKS 생성해보기 (0) | 2025.02.06 |